设施农业典型地物改进Faster R-CNN识别方法

|

王 兴(1992-),男,安徽宿州人,博士生,主要从事深度学习、视频GIS、无线传感网络研究。E-mail: jwangxing0719@163.com |

收稿日期: 2018-12-29

要求修回日期: 2019-05-14

网络出版日期: 2019-09-24

基金资助

国家自然科学基金项目(41771420)

国家高技术研究发展计划项目(2015AA123901)

江苏高校优势学科建设工程资助项目

版权

Improving the Faster R-CNN Method for Recognizing Typical Objects of Modern Agriculture based on Remote Sensing Imagery

Received date: 2018-12-29

Request revised date: 2019-05-14

Online published: 2019-09-24

Supported by

National Natural Science Foundation of China(41771420)

National High-tech R&D Program of China(2015AA123901)

Funded by the Priority Academic Program Development of Jiangsu Higher Education Institution

Copyright

深度学习方法可有效提高传统基于遥感影像的设施农业典型地物识别与提取方法的结果精度,对传统农业的转型和发展意义重大。本文针对遥感影像大背景小目标的特点,以及设施农业典型地物的图像特征,结合深度残差思想和Faster R-CNN提出DRTOMA算法:首先,使用深度残差网络作为其基础特征提取网络,以此获得更深层次的图像特征,并抑制网络退化和衰退问题;然后在残差单元和全连接层之间加入改进的空间金字塔池化层,从而去除输入图像固定大小的限制,增加网络对图像尺度的敏感度;最后,在全连接层间添加dropout层,减少网络计算的复杂度,提升抗过拟合效果。仿真结果表明:同部分已有的检测算法相比,DRTOMA算法的平均识别准确率和召回率均取为最优,分别为91.87%和90.63%;在最优识别精度近似的情况下,DRTOMA算法比Faster R-CNN算法的召回率高约2%,网络更易收敛,训练难度较低。综上所述,DRTOMA算法是一种有效可行的设施农业典型地物检测方法。

关键词: 设施农业; 遥感影像; 目标检测; Faster R-CNN; 深度残差

王兴 , 康俊锋 , 刘学军 , 王美珍 , 张超 . 设施农业典型地物改进Faster R-CNN识别方法[J]. 地球信息科学学报, 2019 , 21(9) : 1444 -1454 . DOI: 10.12082/dqxxkx.2019.180699

The development of modern agriculture is directly related to the transformation of the traditional agriculture. The recognition and extraction of typical objects of modern agriculture (TOMA) through remote sensing imagery has many advantages and has become the mainstream of current applications. Since traditional recognition methods are easily affected by external environmental factors (e.g., the shape, size, color, and texture of TOMA, and the distance, angle, and weather conditions for obtaining the remote sensing imagery), the accuracy of recognition results is usually difficult to meet application requirements. In the recent years, deep learning methods have seen wide applications in many fields, which greatly promote the advancement of artificial intelligence. Convolutional Neural Network (CNN) has acquired breakthrough research results in image classification, object detection, semantic segmentation, and so on. Based on the structure of CNN, many excellent network structures have been developed, such as Regions with CNN, Fast R-CNN, Mask R-CNN, etc. In particula, Faster R-CNN is one of the mainstream algorithms for target detection. However, when directly applied to the recognition of TOMA, the Faster R-CNN still has some drawbacks to be improved, especially the problem of small targets with large background. By taking the image features of TOMA into account, a DRTOMA (Deep Residual TOMA) algorithm was proposed in this paper based on the idea of deep residual network and Faster R-CNN. Firstly, the deep residual network was used as the basic feature extraction network to obtain deeper features and suppress the network degenerate problems. Secondly, an improved spatial pyramid pooling layer was added between the residual unit and the fully connected layer to remove the fixed size limit of the input image while increasing the sensitivity to the scale of the network. Lastly, a dropout layer was added between the fully connected layers to reduce the complexity of the network and improve the over-fitting effect. Simulation results showed that compared with some existing algorithms, the average recognition accuracy and recall rate of the DRTOMA algorithm were optimal, being 91.87% and 90.643%, respectively. The recognition accuracy of the DRTOMA algorithm and that of Faster R-CNN were similar. However, the DRTOMA algorithm had a recall rate of about 2% higher than the Faster R-CNN algorithm, and the network was easier to converge and can be trained for a shorter time. Our findings suggest that the DRTOMA algorithm is an effective and feasible TOMA detection method.

Tab. 1 Common TOMA images and features |

| 典型地物类型 | 地物图像特征 | 特征描述 |

|---|---|---|

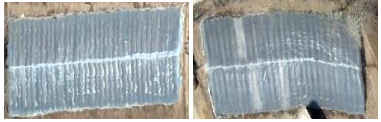

| 地膜 |  | 银白色,一般为长方形,大多分布于温棚基地或蔬果区 |

| 塑料大棚 |  | 透明白色,通常是长方形,多数分布于蔬菜或果园基地 |

| 连栋温室 |  | 透明白色,将几个独立温室连接成大温室,多边形,分布于温棚基地或农田区 |

| 日光温室 |  | 银色或透明白色,通常依附于山体结构,多数为长方形,分布于光照好的地区 |

表2 基础特征提取网络结构Tab. 2 Basic features extraction network structure |

| 残差块 | 特征图尺寸 宽度×长度,维度 | 残差内部结构 宽度×长度,维度 | |

|---|---|---|---|

| 主径 | 捷径 | ||

| 残差单元 1 | 224×224, 64 | 224×224, 32 | |

| 最大池化 | 224×224, 32 | ||

| 残差单元 2 | 112×112, 128 | 112×112, 64 | |

| 最大池化 | 112×112, 64 | ||

| 残差单元 3 | 56×56, 256 | 56×56, 128 | |

| 最大池化 | 56×56, 128 | ||

| 残差单元 4 | 28×28, 512 | 28×28, 256 | |

| 最大池化 | 28×28, 256 | ||

| 残差单元 5 | 14×14, 1024 | 14×14, 512 | |

| 最大池化 | 14×14, 512 | ||

图8 3种深度学习算法训练过程对比Fig. 8 Comparison of training process of the three deep learning algorithms |

表3 各设施农业典型地物识别算法精度实验对比Tab. 3 Accuracy comparison of each TOMA recognizing algorithm (%) |

| SIFT+SVM | AlexNet | Faster R-CNN(VGG16) | DRTOMA | |

|---|---|---|---|---|

| Recall | 60.27 | 75.42 | 88.27 | 90.63 |

| A_accuracy | 54.15 | 80.43 | 91.34 | 91.87 |

| [1] |

刘霓红, 蒋先平, 程俊峰 , 等. 国外有机设施园艺现状及对中国设施农业可持续发展的启示[J]. 农业工程学报, 2018,34(15):1-9.

[

|

| [2] |

陈瑜, 张铁民, 孙道宗 , 等. 基于无线传感器网络的设施农业车辆定位系统设计与试验[J]. 农业工程学报, 2015,31(10):190-197.

[

|

| [3] |

单治彬, 孔金玲, 张永庭 , 等. 面向对象的特色农作物种植遥感调查方法研究[J]. 地球信息科学学报, 2018,20(10):1509-1519.

[

|

| [4] |

宋晓阳, 黄耀欢, 董东林 , 等. 融合数字表面模型的无人机遥感影像城市土地利用分类[J]. 地球信息科学学报, 2018,20(5):703-711.

[

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

王金传, 谭喜成, 王召海 , 等. 基于Faster-RCNN深度网络的遥感影像目标识别方法研究[J]. 地球信息科学学报, 2018,20(10):1500-1508.

[

|

| [12] |

|

| [13] |

李彦冬, 郝宗波, 雷航 . 卷积神经网络研究综述[J]. 计算机应用, 2016,36(9):2508-2515,2565.

[

|

| [14] |

周飞燕, 金林鹏, 董军 . 卷积神经网络研究综述[J]. 计算机学报, 2017,40(6):1229-1251.

[

|

| [15] |

|

| [16] |

|

| [17] |

张慧, 王坤峰, 王飞跃 . 深度学习在目标视觉检测中的应用进展与展望[J]. 自动化学报, 2017,43(8):1289-1305.

[

|

| [18] |

|

| [19] |

罗军, 潘瑜春, 王纪华 , 等. 基于高分辨率遥感影像的设施农业资源信息采集技术研究[J]. 地理与地理信息科学, 2007,23(3):51-54.

[

|

| [20] |

何少林, 徐京华, 张帅毅 . 面向对象的多尺度无人机影像土地利用信息提取[J]. 国土资源遥感, 2013,25(2):107-112.

[

|

| [21] |

曹林林, 李海涛, 韩颜顺 , 等. 卷积神经网络在高分遥感影像分类中的应用[J]. 测绘科学, 2016,41(9):170-175.

[

|

| [22] |

杨嘉树, 梅天灿, 仲思东 . 顾及局部特性的CNN在遥感影像分类的应用[J]. 计算机工程与应用, 2018,54(7):188-195.

[

|

| [23] |

陆永帅, 李元祥, 刘波 , 等. 基于深度残差网络的高光谱遥感数据霾监测[J]. 光学学报, 2017,37(11):314-324.

[

|

/

| 〈 |

|

〉 |