交叉点结构特征约束的机载LiDAR点云与多视角航空影像配准

|

王广帅(1994— ),男,山东菏泽人,硕士生,主要从事激光点云与影像配准研究。E-mail:gs_wang@whu.edu.cn |

收稿日期: 2019-09-10

要求修回日期: 2019-11-12

网络出版日期: 2020-11-25

基金资助

国家自然科学基金项目(41871368)

版权

Registration of Airborne LiDAR Data and Multi-View Aerial Images Constrained by Junction Structure Features

Received date: 2019-09-10

Request revised date: 2019-11-12

Online published: 2020-11-25

Supported by

National Natural Science Foundation of China(41871368)

Copyright

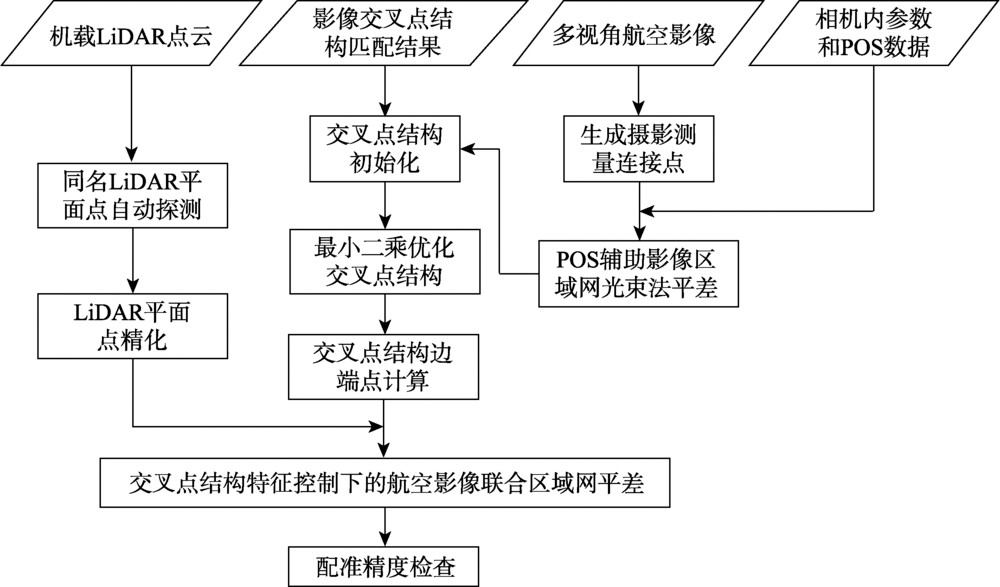

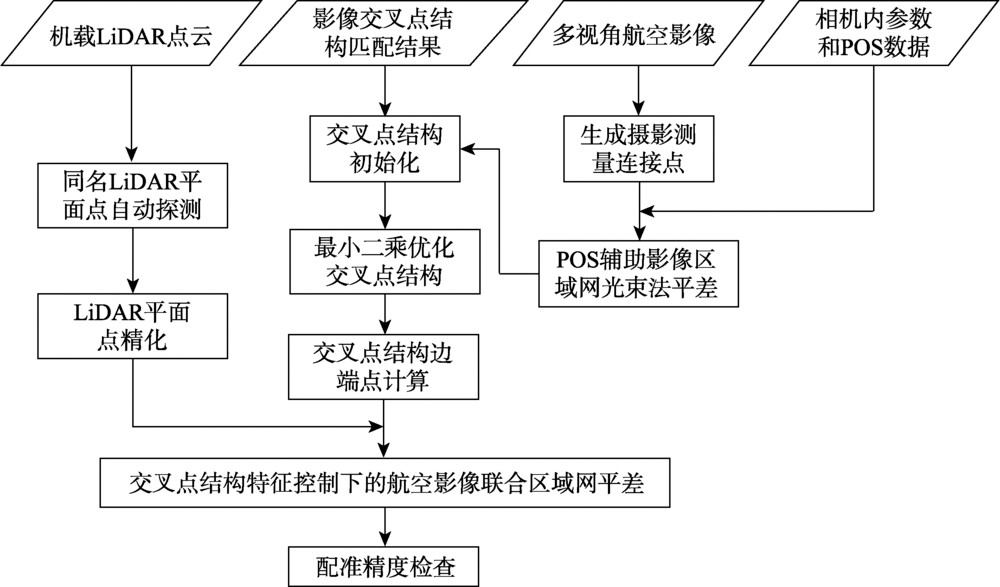

针对机载点云与航空影像配准精度受点云密度影响较大的问题,本文提出一种交叉点结构特征约束下的机载点云影像配准方法。该方法充分利用激光测距精度较高这一优势,采用点云中的平面结构对影像区域网进行绝对定向约束。首先,利用POS辅助平差后的影像内外方位元素和影像交叉点结构匹配结果,以反投影距离为测度,按照最小二乘准则交会得到交叉点物方结构;然后,在LiDAR点云中自动探测交叉点结构的同名LiDAR平面点;最后,进行交叉点结构特征约束下的航空影像联合区域网平差,得到精确的相机内参数和影像外方位元素。实验结果表明,本文方法在平面和高程方向上均可达到1~2个像素的配准精度。与基于建筑物角特征的配准方法相比,有效克服了点云密度对配准精度的影响,当点云密度较低时,本文方法依然可以取得较高的配准精度。

王广帅 , 万一 , 张永军 . 交叉点结构特征约束的机载LiDAR点云与多视角航空影像配准[J]. 地球信息科学学报, 2020 , 22(9) : 1868 -1877 . DOI: 10.12082/dqxxkx.2020.190514

:The integration of Airborne LiDAR data and aerial imagery is useful in data interpretation, land monitoring, and 3D reconstruction. As the first step of these tasks, the geometric registration of the two types of data should be conducted to ensure their alignment. The alignment is sometimes difficult because of differences in their data acquisition mechanisms. The LiDAR data is more reliable and more accurate on smooth surfaces like grounds, walls, and roofs which are difficult to extract from aerial imagery. LiDAR points are mostly sparser than the pixels on aerial images. Considering that the a priori ranging error (1~5 cm) of airborne LiDAR data is usually much smaller than the average point distance (10~50 cm), this paper introduced a plane-constrained block adjustment model to align the two types of data, where the planes were obtained by the intersection of corresponding junction structures. The planar constraints were implemented by forcing surrounding LiDAR points to be on the planes. The proposed block adjustment model is a mixture of the conventional POS-aided and self-calibrated bundle adjustment model and two more types of observing equations. One is the distance between image junction structure observations, and reprojection of the spatial junction structure should be zeros. The other is the normal distance between LiDAR points, and the spatial planes obtained by junction structure should be zeros. In this paper, firstly junction structures in object space were solved based on least squares theory. Then, conjugate planes of junction structures in LiDAR points were detected automatically. Finally, the aerial images block adjustment under constraints of junction structure was performed to obtain the precise interior and exterior orientation parameters. The experimental results showed that both the horizontal and the vertical accuracy of the proposed method could reach 1~2 pixels of the aerial images, which was obviously better than the building-corner-based method. In order to probe into the influence of point cloud density, the LiDAR points were thinned randomly before the geometric registration. The results showed that the accuracy of the proposed method was not influenced but the accuracy of building-corner-based method decreased when the point cloud density decreased, especially the horizontal accuracy. In conclusion, the proposed method takes the advantage of the high-ranging accuracy of LiDAR data to reach high registration accuracy and avoids the influence of the point cloud density. When the density of the LiDAR point cloud is low, a high registration accuracy can be reached using the proposed method.

表1 实验数据详细信息Tab. 1 Details of the experimental data |

| 数据集 | Ⅰ | Ⅱ | |

|---|---|---|---|

| 航空 影像 | 测区位置 | 广州 | 宁波 |

| 航高/m | 500 | 900 | |

| 地面分辨率/m | 0.032 | 0.048 | |

| 像幅大小/pixels | 10 336×7788 | 11 608×8708 | |

| 相机数 | 5 | 5 | |

| 影像总数 | 2415 | 1451 | |

| LiDAR | 点云密度/(pts/m2) | 16 | 10 |

| 点云间距/m | 0.25 | 0.30 | |

| 总点数 | 43 971 092 | 45 154 384 | |

图6 广州测区影像与LiDAR点云概况Fig. 6 Overview of the image data and LiDAR point cloud for the Guangzhou data set |

图8 广州测区部分影像交叉点结构量测结果Fig. 8 Measurements of image junction structures for the Guangzhou data set |

图9 广州某区域点云赋色结果Fig. 9 LiDAR point cloud colored by aerial images for the Guangzhou data set |

图10 广州测区点云影像配准前后投影效果对比Fig. 10 Comparison of the fitness of LiDAR points to images before and after registration for the Guangzhou data |

表2 广州测区配准精度对比Tab. 2 Comparison of registration accuracy for the Guangzhou data set |

| 类别 | 角特征配准方法/m | 交叉点配准方法/m | |||

|---|---|---|---|---|---|

| dXY | dZ | dXY | dZ | ||

| 残差中误差 | 0.052 | 0.101 | 0.042 | 0.058 | |

| 残差平均值 | 0.035 | 0.069 | 0.038 | 0.054 | |

| 残差最大值 | 0.126 | 0.249 | 0.116 | 0.097 | |

表3 宁波测区检查点残差对比Tab. 3 Comparison of check points residuals for the Ningbo data set |

| 类别 | 角特征配准方法/m | 交叉点配准方法/m | |||||||

|---|---|---|---|---|---|---|---|---|---|

| dX | dY | dXY | dZ | dX | dY | dXY | dZ | ||

| 残差中误差 | 0.076 | 0.063 | 0.109 | 0.100 | 0.051 | 0.025 | 0.057 | 0.063 | |

| 残差平均值 | -0.031 | 0.002 | 0.089 | 0.062 | 0.045 | 0.003 | 0.051 | -0.044 | |

| 残差最大值 | -0.176 | -0.141 | 0.183 | 0.296 | 0.096 | -0.054 | 0.099 | -0.112 | |

| [1] |

|

| [2] |

|

| [3] |

袁鹏飞, 黄荣刚, 胡平波, 等. 基于多光谱LiDAR数据的道路中心线提取[J]. 地球信息科学学报, 2018,20(4):452-461.

[

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

程亮, 龚健雅, 李满春, 等. 集成多视航空影像与LiDAR数据重建3维建筑物模型[J]. 测绘学报, 2009,38(6):494-501.

[

|

| [9] |

|

| [10] |

|

| [11] |

张靖, 江万寿. 激光点云与光学影像配准:现状与趋势[J]. 地球信息科学学报, 2017,19(4):528-539.

[

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

张永军, 熊小东, 沈翔. 城区机载LiDAR数据与航空影像的自动配准[J]. 遥感学报, 2012,16(3):579-595.

[

|

| [22] |

张良, 马洪超, 高广, 等. 点、线相似不变性的城区航空影像与机载激光雷达点云自动配准[J]. 测绘学报, 2014,43(4):372-379.

[

|

| [23] |

|

/

| 〈 |

|

〉 |