基于PRCUnet的高分遥感影像建筑物提取

|

徐佳伟(1997— ),男,江苏南京人,硕士生,主要从事深度学习、遥感图像分析处理研究。E-mail: xujiawei@jsnu.edu.cn |

收稿日期: 2021-05-21

要求修回日期: 2021-07-09

网络出版日期: 2021-12-25

基金资助

江苏省研究生科研与实践创新计划项目(KYCX20_2364)

江苏高校优势学科建设工程资助项目

徐州市重点研发计划(社会发展)项目(KC20172)

徐州市重点研发计划(社会发展)项目(KC20172)

资源与环境信息系统国家重点实验室开放基金项目

江苏省自然资源厅科技创新项目(2021046)

江苏省地质矿产勘查局科研项目(2020KY11)

版权

High-Resolution Remote Sensing Image Building Extraction based on PRCUnet

Received date: 2021-05-21

Request revised date: 2021-07-09

Online published: 2021-12-25

Supported by

Postgraduate Research & Practice Innovation Program of Jiangsu Province(KYCX20_2364)

A Project Funded by the Priority Academic Program Development of Jiangsu Higher Education Institutions

Xuzhou Science and Technology Key R&D Program (Social Development) under Project(KC20172)

Xuzhou Science and Technology Key R&D Program(KC20172)

Open Fund of National Key Laboratory of Resource and Environment Information System

Jiangsu Province Land and Resources Science and Technology Plan Project(2021046)

Jiangsu Geology&Mineral Exploration Bureau Science and Technology Plan Project(2020KY11)

Copyright

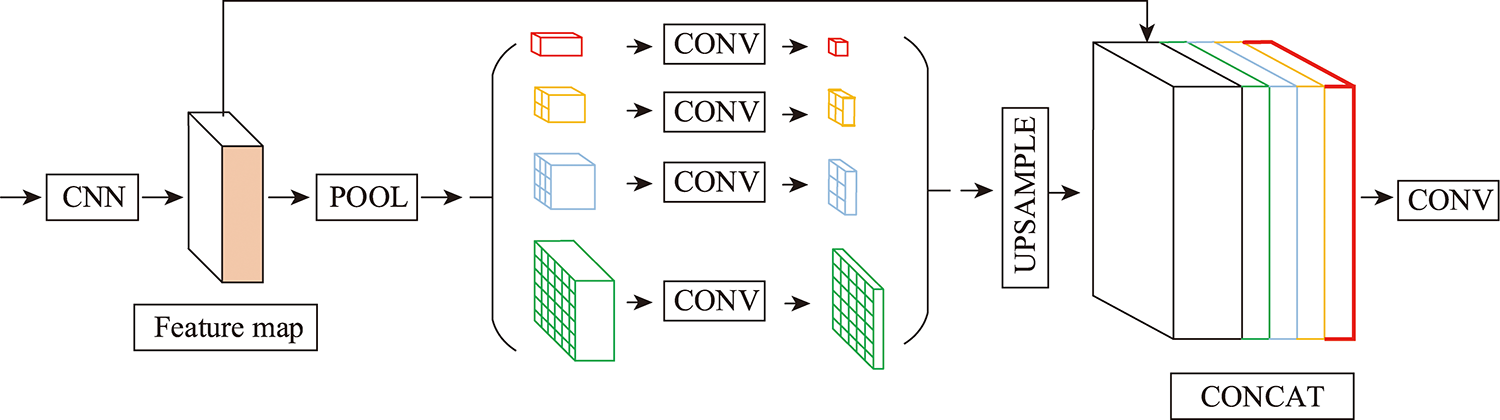

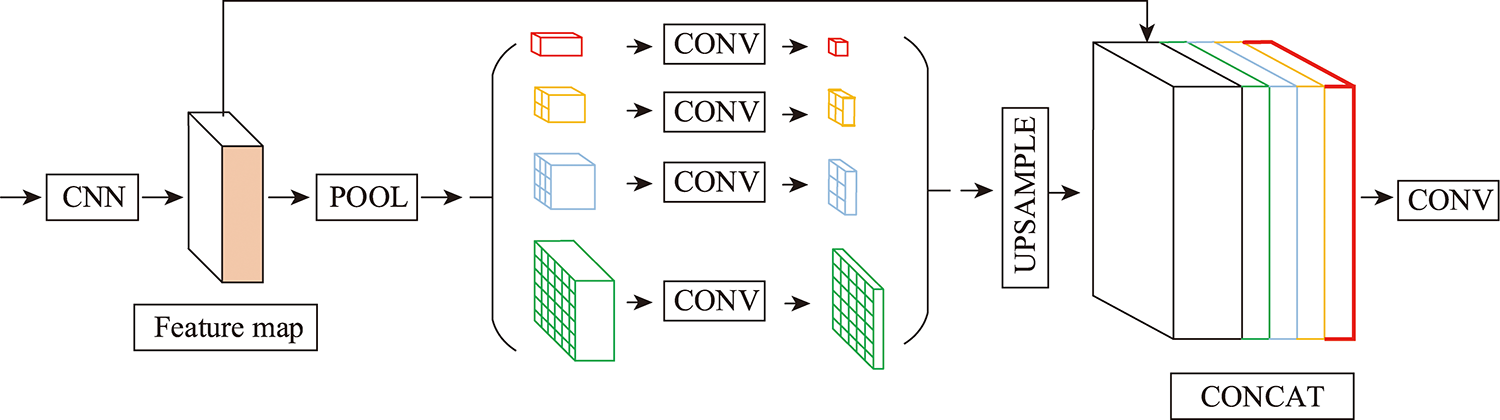

基于高分辨率遥感影像的建筑物提取具有重要的理论与实际应用价值,深度学习因其优异的深层特征提取能力,已经成为高分影像提取建筑物的主流方法之一。本文在改进深度学习网络结构的基础上,结合最小外接矩形与Hausdorff距离概念,对建筑物提取方法进行改进。本文主要改进内容为:① 基于Unet网络结构,利用金字塔池化模块 (Pyramid Pooling Module, PPM )的多尺度场景解析特点,残差模块(Residual Block, RB)的特征提取能力以及卷积块注意力模块(Convolutional Block Attention Module, CBAM)对空间信息和通道信息的平衡能力。将金字塔池化、残差结构以及卷积块注意力模块引入到Unet模型中,建立PRCUnet模型。PRCUnet模型更关注语义信息和细节信息,弥补Unet对小目标检测的欠缺;② 基于最小外接矩形与Hausdorff距离,改进建筑物轮廓优化算法,提高模型的泛化能力。实验表明,本文的建筑物提取方法在测试集上准确率、IoU、召回率均达到0.85以上,精度显著优于Unet模型,提取出的建筑物精度更高,对小尺度及不规则的建筑物有较好的提取效果,优化后的建筑物轮廓更接近真实的建筑物边界。

徐佳伟 , 刘伟 , 单浩宇 , 史嘉诚 , 李二珠 , 张连蓬 , 李行 . 基于PRCUnet的高分遥感影像建筑物提取[J]. 地球信息科学学报, 2021 , 23(10) : 1838 -1849 . DOI: 10.12082/dqxxkx.2021.210283

Building extraction based on high-resolution remote sensing images has important theoretical and practical applications. Deep learning has become one of the mainstream methods for extracting buildings from high-resolution images because of its excellent deep feature extraction ability. In this paper, based on an improved structure of deep learning network, we combined the concept of minimum outer rectangle and Hausdorff distance to improve the building extraction method. The main improvements in this paper are: ① Based on the Unet network structure, we employed the multi-scale feature detection ability of Pyramid Pooling Module (PPM), the great feature extraction capability of Residual Block (RB), and the ability to balance spatial and channel information of Convolutional Block Attention Module (CBAM). The PPM, RB, and CBAM were introduced to the Unet model to build the PRCUnet model, which focuses more on semantic and detailed information and overcomes the limitation of Unet in small target detection; ② We improved the building contour optimization algorithm based on the minimum outer rectangle and Hausdorff distance to improve the generalization ability of the model. Experiments show that the accuracy, IoU, and recall of the building extraction method proposed in this paper reached above 0.85 using the test set, significantly higher than those of the Unet model. The PRCUnet model also had better extraction effect on small-scale and irregular buildings than Unet, and the optimized building contours were close to the real building boundaries.

表1 实验环境Tab.1 Experimental environment |

| CPU | GPU | Memory | System | TensorFlow | Keras | Python | CUDA | CUDNN |

|---|---|---|---|---|---|---|---|---|

| Intel(R) Xeon(R) CPU E5- V4 | 2×Quadro P4000 | 16GB | Ubuntu 16.04 | 2.0 | 2.1.5 | 3.7 | 9.2 | 7.6.5 |

表2 超参数设置Tab.2 Hyper parameter configuration |

| Unet | Unet+ResBlock | Unet+ResBlock+PPM | PRCUnet | |

|---|---|---|---|---|

| 迭代次数 | 61 | 63 | 63 | 58 |

| 学习率 | 1e-4 | 1e-4 | 1e-4 | 1e-4 |

| 批次大小 | 16 | 16 | 16 | 16 |

| 图像增强 | 是 | 是 | 是 | 是 |

表3 PRCUnet评价指标Table 3 PRCUnet Evaluation index |

| 模型 | Accuracy | IoU | Recall |

|---|---|---|---|

| Unet | 0.873 | 0.753 | 0.801 |

| Unet+RB | 0.886 | 0.774 | 0.825 |

| Unet+RB+PPM | 0.905 | 0.821 | 0.853 |

| PRCUnet | 0.921 | 0.851 | 0.877 |

| PRCUnet+轮廓优化 | - | 0.882 | - |

| [1] |

林祥国, 张继贤. 面向对象的形态学建筑物指数及其高分辨率遥感影像建筑物提取应用[J]. 测绘学报, 2017, 46(6):724-733.

[

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

胡翔云, 巩晓雅, 张觅. 变分法遥感影像人工地物自动检测[J]. 测绘学报, 2018, 47(6):780-789.

[

|

| [9] |

范荣双, 陈洋, 徐启恒, 等. 基于深度学习的高分辨率遥感影像建筑物提取方法[J]. 测绘学报, 2019, 48(1):38-45.

[

|

| [10] |

龚健雅, 季顺平. 摄影测量与深度学习[J]. 测绘学报, 2018, 47(6):693-704.

[

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

柳娜, 孙晓亮, 谭毅华. 基于最小外接矩形的直角多边形拟合算法[J]. 计算机科学, 2017, 44(6):294-297,305.

[

|

| [30] |

常京新, 王双喜, 杨元维, 等. 高分遥感影像建筑物轮廓的逐级优化方法[J]. 中国激光, 2020, 47(10):249-262.

[

|

| [31] |

住房和城乡建设部信息中心. 全国试点地区房屋建筑和市政设施调查底图制备项目公开招标公告[A/OL]. http://www.ccgp.gov.cn/cggg/zygg/gkzb/202009/t20200929_15168096.html 2020-10-20.

[ Information Center of Ministry of Housing and Urban-Rural Development. National pilot area housing construction and municipal facilities survey base map preparation project public tender announcement[A/OL]. http://www.ccgp.gov.cn/cggg/zygg/gkzb/202009/t20200929_15168096.html 2020-10-20. ]

|

/

| 〈 |

|

〉 |