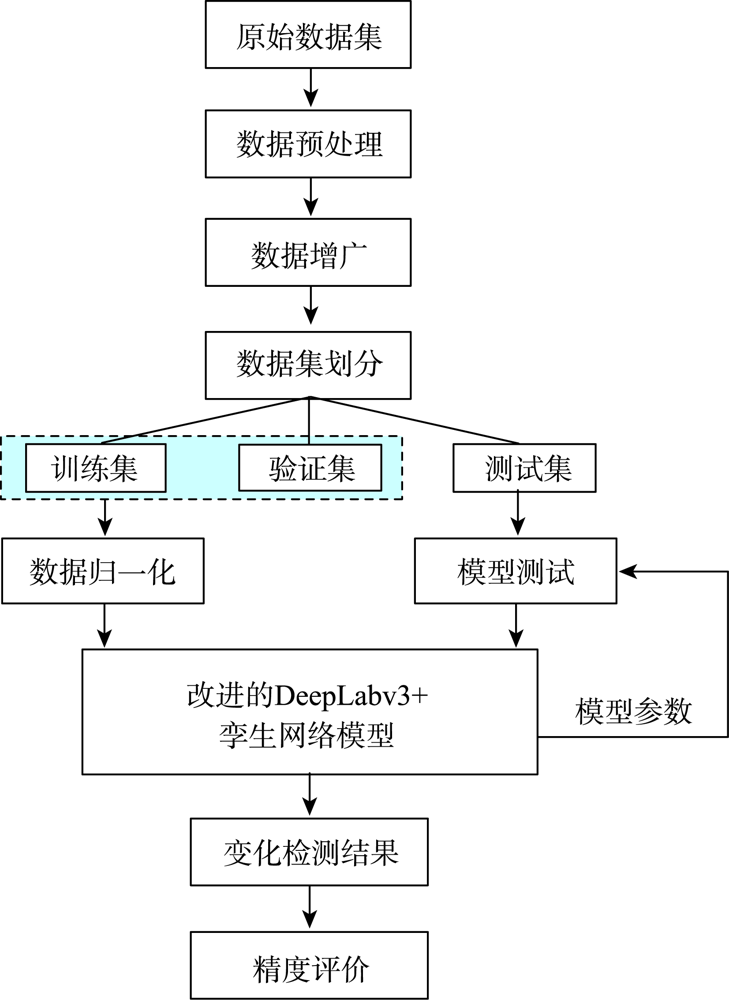

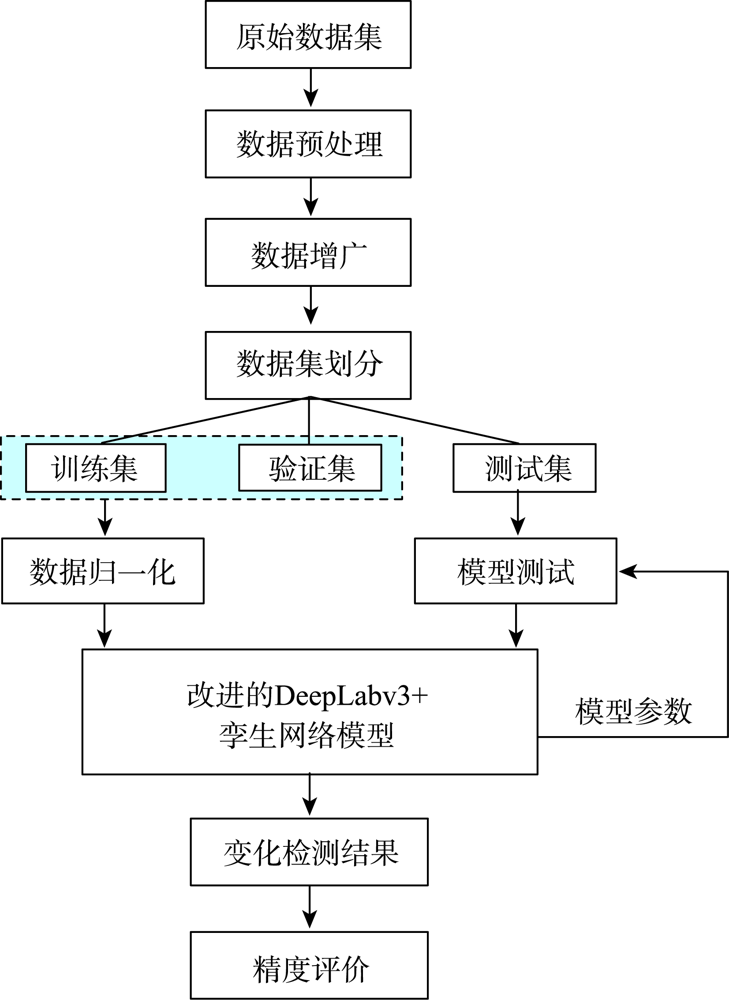

基于改进DeepLabv3+孪生网络的遥感影像变化检测方法

|

赵 祥(1997— ),男,河南洛阳人,硕士生,主要从事计算机视觉、遥感图像处理等方向研究。E-mail: zx15538019261@163.com |

收稿日期: 2022-01-17

修回日期: 2022-04-19

网络出版日期: 2022-10-25

基金资助

装备技术基础科研项目(192WJ22007)

Remote Sensing Image Change Detection based on Improved DeepLabv3+ Siamese Network

Received date: 2022-01-17

Revised date: 2022-04-19

Online published: 2022-10-25

Supported by

Equipment Technology Basic Scientific Research Project(192WJ22007)

传统遥感影像变化检测方法依赖人工构建特征,算法设计复杂且精度不高;而将2幅不同时相影像叠加后输入神经网络的遥感影像变化检测方法会造成不同时相的特征相互影响,难以保持原始影像的高维特征,且模型鲁棒性较差。因此,本文提出一种基于改进DeepLabv3+孪生网络的遥感影像变化检测方法,以经典DeepLabv3+网络的编解码结构为基础对网络进行改进:① 在编码阶段利用共享权值的孪生网络提取特征,通过2个输入端分别接收2幅遥感影像,以保留不同时相影像的高维特征;② 在特征融合中用密集空洞空间金字塔池化模型代替空洞空间金字塔池化模型,通过密集连接的方式结合每个空洞卷积的输出,以提高对不同尺度目标分割的精度;③ 在解码阶段中针对不同层级特征图信息差异较大,难以融合的问题,引入基于注意力机制的特征对齐模型,引导不同层级的特征对齐并强化学习重要特征,以提升模型的鲁棒性。应用开源数据集CDD验证本文方法的有效性,并与UNet-EF、FC-Siam-conc、Siam-DeepLabv3+和N-Siam-DeepLabv3+网络对比试验。试验结果表明,本文方法在精确率、召回率、F1值和总体精度上达到87.3%、90.2%、88.4%、96.4%,均高于UNet-EF、FC-Siam-conc、Siam-DeepLabv3+网络和N-Siam-DeepLabv3+网络,检测结果较为完整,对边界的检测也更为平滑,且对尺度变化具有更高的鲁棒性。

赵祥 , 王涛 , 张艳 , 郑迎辉 , 张昆 , 王龙辉 . 基于改进DeepLabv3+孪生网络的遥感影像变化检测方法[J]. 地球信息科学学报, 2022 , 24(8) : 1604 -1616 . DOI: 10.12082/dqxxkx.2022.220029

Traditional remote sensing image change detection method relies on artificial construction of features, and the algorithm design is complex and has a low accuracy. Moreover, the remote sensing image change detection technique, which superimposes two different phase images and then inputs them into the neural network, will cause the interaction of characteristics of different phases. It is difficult to maintain the high-dimensional features of the original image, and the model is less robust. Therefore, this paper proposes a remote sensing image change detection method that improves the DeepLabv3+ Siamese network based on the encoding and decoding structure of the classic DeepLabv3+ network: 1) In the encoding stage, the features are extracted by the Siamese network sharing weights, and remote sensing images are received through two input terminals respectively, so as to preserve the high-dimensional features of different time-phase images; 2) The dense atrous space pyramid pooling model replaces the atrous space pyramid pooling model in feature fusion. In addition, the method that combines the output of each atrous convolution through dense connections improves the segmentation of objects of different scales; 3) In the decoding stage, multiple levels of feature map information contain variance that causes integration problems. As a result, a feature alignment model based on the attention mechanism is introduced to guide the feature alignment of different levels, and then strengthen the learning of critical features to enhance model robustness. The open-source dataset CDD is used to verify the efficacy of the method in this paper, compared with UNet-EF, FC-Siam-conc, Siam-DeepLabv3+ and N-Siam-DeepLabv3+ networks. The test results demonstrate that the presented approach in the study achieves 87.3%、90.2%、88.4%、96.4% in precision rate, recall rate, F1 value, and overall accuracy, respectively, which are higher than those of the UNet-EF, FC-Siam-conc, Siam-DeepLabv3+ and N-Siam-DeepLabv3+ networks. The detection results turn out to be more comprehensive, and the boundary detection is smoother and more robust to scale changes.

表1 硬件和软件环境配置信息Tab. 1 Hardware and software environment configuration information |

| 实验环境 | 名称 | 参数信息 |

|---|---|---|

| 硬件环境 | CPU | Intel Xeon E5 |

| 内存大小 | 32 G | |

| GPU | GeForce RTX 2080Ti | |

| 显存大小 | 11 G | |

| 操作系统 | Windows10 | |

| 软件环境 | 深度学习框架 | Pytorch1.9.0 |

| CUDA | Cuda10.2 | |

| 编程语言 | Python3.7.10 | |

| 开发环境 | Pycharm2019 |

表2 模型参数配置Tab. 2 Model parameter configuration |

| 参数 | 值 |

|---|---|

| 初始学习率 | 0.0001 |

| 批处理大小 | 8 |

| 最大迭代次数 | 100 |

| 优化器 | Adam |

表3 变化检测混淆矩阵Tab. 3 Change detection confusion matrix |

| 预测变化类 | 预测未变化类 | |

|---|---|---|

| 实际变化类 | TP | FN |

| 实际未变化类 | FP | TN |

表4 变化检测结果精度对比Tab. 4 Accuracy comparison of change detection results |

| 方法 | 评价指标 | ||||

|---|---|---|---|---|---|

| /% | /% | /% | /% | 参数量(M) | |

| UNet-EF | 72.5 | 76.3 | 73.2 | 90.4 | 7.76 |

| FC-Siam-conc | 74.7 | 78.5 | 75.3 | 92.5 | 1.55 |

| Siam-DeepLabv3+ | 85.8 | 87.9 | 86.5 | 94.7 | 40.30 |

| N-Siam-DeepLabv3+ | 85.4 | 88.5 | 87.1 | 95.9 | 59.30 |

| 本文方法 | 87.3 | 90.2 | 88.4 | 96.4 | 42.20 |

表5 模型间的消融实验精度对比Tab. 5 Accuracy comparison of ablation experiments between models |

| DenseASPP | A-FAM | /% | /% | /% | /% | |

|---|---|---|---|---|---|---|

| 实验1 | - | - | 85.8 | 87.9 | 86.5 | 94.7 |

| 实验2 | √ | - | 86.2 | 89.1 | 87.4 | 95.8 |

| 实验3 | - | √ | 86.7 | 88.4 | 87.1 | 95.6 |

| 实验4 | √ | √ | 87.3 | 90.1 | 88.4 | 96.4 |

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

眭海刚, 冯文卿, 李文卓, 等. 多时相遥感影像变化检测方法综述[J]. 武汉大学学报·信息科学版, 2018, 43(12):1885-1898.

[

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

吴瑞娟, 何秀凤, 王静. 结合像元级与对象级的滨海湿地变化检测方法[J]. 地球信息科学学报, 2020, 22(10):2078-2087.

[

|

| [9] |

|

| [10] |

|

| [11] |

王昶, 张永生, 王旭, 等. 基于深度学习的遥感影像变化检测方法[J]. 浙江大学学报(工学版), 2020, 54(11):2138-2148.

[

|

| [12] |

程文胜. 基于语义分割的高分辨率遥感图像变化检测[D]. 武汉: 武汉大学, 2020.

[

|

| [13] |

张翠军, 安冉, 马丽. 改进U-Net的遥感图像中建筑物变化检测[J]. 计算机工程与应用, 2021, 57(3):239-246.

[

|

| [14] |

王民水, 孔祥明, 陈学业, 等. 基于随机补片和DeepLabv3+的建筑物遥感图像变化检测[J/OL]. 吉林大学学报(地球科学版), 2021:1-7.

[

|

| [15] |

|

| [16] |

李紫薇, 于晓鹏, 丁婷婷. 基于编码-解码神经网络遥感图像语义分割应用研究[J]. 智能计算机与应用, 2021, 11(1):106-113.

[

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

付威福. 基于深度学习的遥感影像变化检测算法研究[D]. 成都: 电子科技大学, 2021:1-75.

[

|

| [21] |

孟俊熙, 张莉, 曹洋, 等. 基于DeepLabv3+的图像语义分割算法优化研究[J/OL]. 激光与光电子学进展, 2021:1-15.

[

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

倪良波, 卢涵宇, 卢天健, 等. 基于孪生残差神经网络的遥感影像变化检测[J]. 计算机工程与设计, 2020, 41(12):3451-3457.

[

|

| [26] |

李頔, 王艳, 马宗庆, 等. 基于DenseASPP模型的超声图像分割[J]. 四川大学学报(自然科学版), 2020, 57(4):741-748.

[

|

| [27] |

|

| [28] |

王红君, 季晓宇, 赵辉, 等. SENet优化的DeepLabv3+淡水鱼体语义分割[J]. 中国农机化学报, 2021, 42(2):158-163.

[

|

| [29] |

|

| [30] |

袁洲, 郭海涛, 卢俊, 等. 融合UNet++网络和注意力机制的高分辨率遥感影像变化检测算法[J]. 测绘科学技术学报, 2021, 38(2):155-159.

[

|

/

| 〈 |

|

〉 |