基于分层极限学习机影像转换的多源影像变化检测方法

|

韩 特(1995— ),男,宁夏银川人,博士生,主要从事多源遥感影像的变化检测方法研究。E-mail: tehanrs@163.com |

收稿日期: 2022-03-02

修回日期: 2022-04-05

网络出版日期: 2023-01-25

基金资助

国家重点研发计划项目(2018YFA06055)

国家自然科学基金项目(41971313)

湖南省自然科学基金项目(2019JJ40372)

Heterogeneous Images Change Detection Method based on Hierarchical Extreme Learning Machine Image Transformation

Received date: 2022-03-02

Revised date: 2022-04-05

Online published: 2023-01-25

Supported by

National Key Research and Development Program of China(2018YFA06055)

National Natural Science Foundation of China(41971313)

Natural Science Foundation of Hunan Province(2019JJ40372)

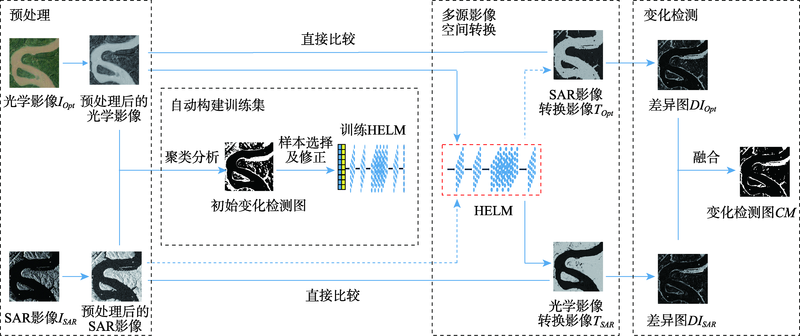

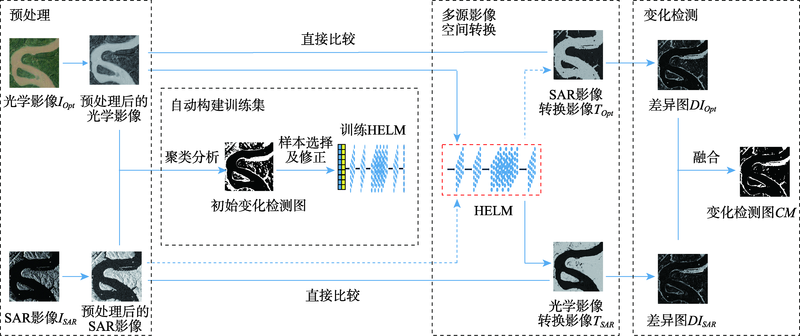

为提高现有多源影像无监督变化检测方法存在的检测结果易受噪声影响和计算效率低等问题,本文提出了一种基于分层极限学习机影像转换的多源影像变化检测方法。分层极限学习机(Hierarchical Extreme Learning Machine, HELM)通过多层前向编码获得丰富的特征表示,且当特征提取完成即可确定网络参数。本文方法首先通过对合成孔径雷达(Synthetic Aperture Radar, SAR)影像进行对数转换,以获得与光学影像相同的影像噪声分布,并利用影像平滑减少影像噪声对变化检测结果的影响;然后分别对多源影像进行聚类分析,通过对比两时相影像的聚类图获得初始变化检测图,选取初始变化检测图中的未变化区域的像元作为初始训练样本,构建训练样本修正模型修正初始训练样本以提高训练样本的准确性;引入HELM以实现多源影像特征空间转换,获取多时相空间转换影像,提高了算法效率;最后通过对比原始影像和多时相空间转换影像获取变化信息。两组多源影像(Google Earth和哨兵1号影像)的实验结果表明:与现有方法相比,本文方法的Kappa系数分别至少提高了6.19%和8.94%,证明了本文方法对多源影像变化检测的有效性。

韩特 , 汤玉奇 , 邹滨 , 冯徽徽 , 张芳艳 . 基于分层极限学习机影像转换的多源影像变化检测方法[J]. 地球信息科学学报, 2022 , 24(11) : 2212 -2224 . DOI: 10.12082/dqxxkx.2022.220089

Due to the complementary information between different imaging mechanisms, heterogeneous image change detection is a challenging and hot topic compared to homogeneous image change detection. Its application is widespread, especially in emergency situations caused by natural disasters. To address the limitations of existing methods such as susceptibility to noise, manually selecting samples, and time-consuming computation, we propose a change detection method for heterogeneous images based on image transformation using Hierarchical Extreme Learning Machine (HELM). In our method, a HELM transformation model between heterogeneous images is constructed, which transforms the image features of one image into the feature space of the other one. Consequently, the transformed multi-temporal images could be comparable. Specifically, first, the logarithmic transformation of SAR images is carried out to obtain the same noise distribution model with the optical image. These heterogeneous images are smoothed to reduce the impact of image noise. Then, through image segmentation, the unchanged areas are selected as training samples. And a correction model for training samples is constructed to avoid manual selection of samples and improve the accuracy of image transformation. Subsequently, the corrected training samples are used to train the HELM to obtain the multi-temporal transformation images, which avoids the parameter adjustment of neural networks. Finally, the changes could be extracted by comparing the transformed multi-temporal images. To prove the effectiveness of the method, two sets of heterogeneous images (Google Earth and Sentinel 1 images) are used for experimental validation in this paper. The results show that the kappa coefficients of the method for the two data sets are improved by 6.19% and 8.94%, respectively, compared with the existing methods, which proves the effectiveness of the proposed method.

表1 不同方法在长江某流域数据集上的变化检测结果精度比较Table 1 Quantitative analysis of different methods on on Yangtze River dataset |

| 方法 | FP | FN | OE | PCC/% | KC | run time/s |

|---|---|---|---|---|---|---|

| HPT | 22 007 | 7842 | 29 849 | 91.71 | 0.6854 | 177.19 |

| LTFL | 24 538 | 4108 | 28 646 | 92.04 | 0.7119 | 2596.56 |

| CGAN | 5961 | 25 377 | 31 338 | 91.30 | 0.5551 | 860.47 |

| NPSG | 17 714 | 20 351 | 38 065 | 89.43 | 0.5394 | 655.89 |

| INLPG | 2626 | 21 436 | 24 062 | 93.32 | 0.6605 | 162.09 |

| 消融实验1 | 5891 | 16 800 | 22 691 | 93.69 | 0.7391 | 38.89 |

| 消融实验2 | 5347 | 16 650 | 21 997 | 93.88 | 0.7463 | 40.85 |

| 本文方法 | 5995 | 13 639 | 19 634 | 94.55 | 0.7800 | 45.76 |

表2 不同方法在瓜州县数据集上的变化检测结果精度比较Table 2 Quantitative analysis of different methods on on Guazhou dataset |

| 方法 | FP | FN | OE | PCC/% | KC | run time/s |

|---|---|---|---|---|---|---|

| HPT | 43 655 | 40 911 | 84 566 | 91.35 | 0.6039 | 628.32 |

| LTFL | 34 695 | 43 109 | 77 804 | 92.04 | 0.6206 | 4358.68 |

| CGAN | 9588 | 78 360 | 87 948 | 91.00 | 0.4490 | 2295.29 |

| NPSG | 88 961 | 57 265 | 144 226 | 85.25 | 0.3831 | 1858.14 |

| INLPG | 17 459 | 67 620 | 85 079 | 91.30 | 0.5100 | 813.25 |

| 消融实验-1 | 48 611 | 33 045 | 81 656 | 91.64 | 0.6340 | 123.23 |

| 消融实验-2 | 47 630 | 33 360 | 80 990 | 91.71 | 0.6354 | 110.23 |

| 本文方法 | 24 187 | 40 351 | 64 538 | 93.40 | 0.6761 | 128.08 |

| [1] |

张良培, 武辰. 多时相遥感影像变化检测的现状与展望[J]. 测绘学报, 2017, 46(10):1447-1459.

[

|

| [2] |

王丽云, 李艳, 汪禹芹. 基于对象变化矢量分析的土地利用变化检测方法研究[J]. 地球信息科学学报, 2014, 16(2):307-313.

[

|

| [3] |

冯文卿, 眭海刚, 涂继辉, 等. 高分辨率遥感影像的随机森林变化检测方法[J]. 测绘学报, 2017, 46(11):1880-1890.

[

|

| [4] |

陈赛楠, 蒋弥. Sentinel-1 SAR在洪水范围提取与极化分析中的应用研究[J]. 地球信息科学学报, 2021, 23(6):1063-1070.

[

|

| [5] |

|

| [6] |

|

| [7] |

曹州, 刘士彬, 马勇, 等. 一种联合光谱-对象-时间特征的遥感影像变化检测方法[J]. 中国科学院大学学报, 2022, 39(1):102-109.

[

|

| [8] |

汤玉奇. 面向对象的高分辨率影像城市多特征变化检测研究[D]. 武汉: 武汉大学, 2013.

[

|

| [9] |

王艳恒, 高连如, 陈正超, 等. 结合深度学习和超像元的高分遥感影像变化检测[J]. 中国图象图形学报, 2020, 25(6):1271-1282.

[

|

| [10] |

张鑫龙, 陈秀万, 李飞, 等. 高分辨率遥感影像的深度学习变化检测方法[J]. 测绘学报, 2017, 46(8):999-1008.

[

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

Google Earth数据(2018)[EB/OL]. https://google-earth.gosur.com/cn/

[Google Earth data(2018)[EB/OL]. https://google-earth.gosur.com/cn/

|

| [29] |

Sentinel卫星数据[EB/OL]. https://scihub.copernicus.eu/dhus/#/home

[Sentinel satellite data (2018)[EB/OL]. https://scihub.copernicus.eu/dhus/#/home

|

/

| 〈 |

|

〉 |