耦合卷积神经网络与注意力机制的无人机摄影测量果树树冠分割方法

|

何海清(1983— ),男,江西赣州人,博士,教授,博士生导师,主要从事摄影测量与遥感、人工智能等方面的研究。E-mail: hyhqing@163.com |

收稿日期: 2023-07-04

修回日期: 2023-08-09

网络出版日期: 2023-12-05

基金资助

国家自然科学基金项目(42261075)

国家自然科学基金项目(41861062)

江西省自然科学基金资助项目(20224ACB212003)

地理信息工程国家重点实验室

自然资源部测绘科学与地球空间信息技术重点实验室联合资助基金项目(2022-02-04)

Fruit Tree Canopy Segmentation by Unmanned Aerial Vehicle Photogrammetry Coupled on Convolutional Neural Network and Attention Mechanism

Received date: 2023-07-04

Revised date: 2023-08-09

Online published: 2023-12-05

Supported by

National Natural Science Foundation of China under Grants(42261075)

National Natural Science Foundation of China under Grants(41861062)

Jiangxi Provincial Natural Science Foundation under Grant(20224ACB212003)

State Key Laboratory of Geo-information Engineering and Key Laboratory of Surveying and Mapping Science and Geospatial Information Technology of MNR, CASM under Grant(2022-02-04)

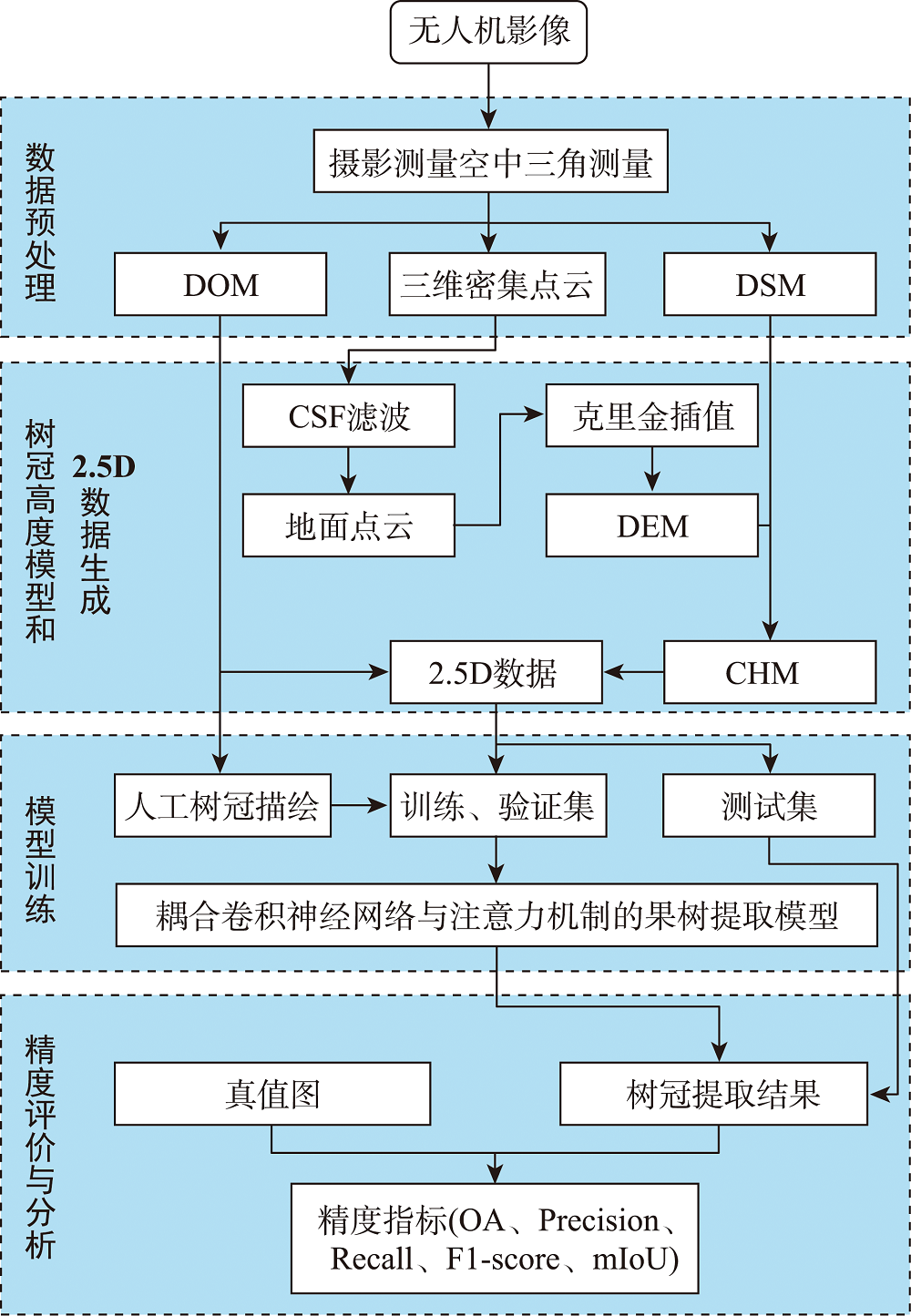

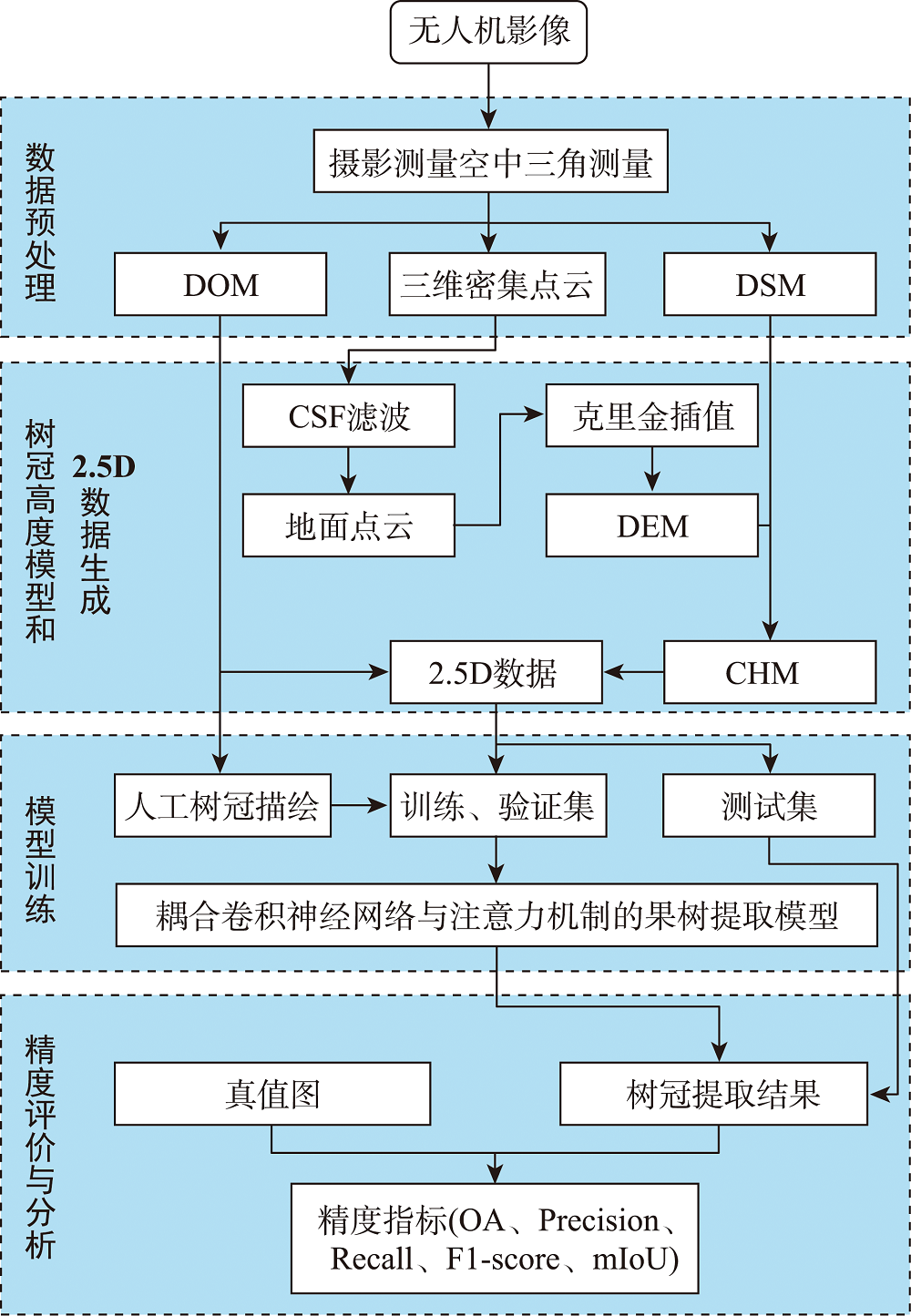

基于无人机可见光影像的果树树冠分割易受地形起伏、灌木及杂草等复杂背景影响,尽管现有深度神经网络能在一定程度上提高树冠分割的鲁棒性,但因受感受野和信息交互限制而忽略了树冠全局上下文和局部细节信息,制约了树冠分割精度进一步提高。针对此,本文引入果树高度模型与深度学习算法,提出一种耦合卷积神经网络与注意力机制的无人机摄影测量果树树冠分割方法。该方法首先通过迁移学习构建基于卷积神经网络与注意力机制的耦合深度网络模型来提取果树树冠局部和全局上下文高级语义特征;同时,顾及深度语义特征与果树树冠位置关联性,设计了局部与全局特征融合模块来实现属性与空间位置协同树冠分割。以柑橘果树树冠分割为例,实验结果表明,引入树冠高度模型能有效抑制地形起伏影响,提出的方法总体精度、F1评分和均交并比最高分别达到97.57%、95.49%和94.05%,能显著削弱低矮杂草或灌木对树冠提取的干扰。此外,与SegFormer、SETR_PUP、TransUNet、TransFuse和CCTNet等先进网络模型相比,均交并比分别提升了1.79%、8.83%、1.16%、1.43%和1.85%。提出的方法可实现复杂背景下果树树冠高精度分割,对于掌握果树生长状况和果园精细化管理具有重要的实用价值。

何海清 , 周福阳 , 陈敏 , 陈婷 , 官云兰 , 曾怀恩 , 魏燕 . 耦合卷积神经网络与注意力机制的无人机摄影测量果树树冠分割方法[J]. 地球信息科学学报, 2023 , 25(12) : 2387 -2401 . DOI: 10.12082/dqxxkx.2023.230370

The segmentation of fruit tree canopy based on Unmanned Aerial Vehicle (UAV) visible spectral images is greatly influenced by complex background information such as topographic relief, shrubs, and weeds. Although existing deep neural networks can improve the robustness of canopy segmentation to a certain extent, they ignore the global context and local detailed information of the canopy due to limited receptive field and information interaction, which restricts the improvement of canopy segmentation accuracy. To address these issues, this paper introduces the Canopy Height Model (CHM) and deep learning algorithms, and proposes a fruit tree canopy segmentation method that couples Convolutional Neural Networks (CNN) and Attention Mechanisms (AM) based on UAV photogrammetry. This method first constructs a coupled deep neural network based on CNN and AM through transfer learning to extract both the local and global high-level contextual features of fruit tree canopies. Meanwhile, considering the correlation between deep semantic features and the position information of fruit tree canopies, a local and global feature fusion module is designed to achieve collaborative tree canopy segmentation of attributes and spatial positions. Taking the citrus tree canopy segmentation as an example, the experimental results demonstrate that the use of the CHM can effectively suppress the influence of topographic relief. Our proposed method can also significantly reduce the interference of underlying weeds or shrubs on canopy segmentation, and achieves the highest Overall Accuracy (OA), F1 score, and mean Intersection over Union (mIoU) of 97.57%, 95.49%, and 94.05%, respectively. Compared with other state-of-the-art networks such as SegFormer, SETR_PUP,TransUNet, TransFuse, and CCTNet, the mIoU obtained by the proposed method increases by 1.79%, 8.83%, 1.16%, 1.43%, and 1.85%, respectively. The proposed method can achieve high-precision segmentation of fruit tree canopies with complex background information, which has important practical value for understanding the growth status of fruit trees and fine management of orchards.

表1 LGFFM、CA和Lossaux的消融实验结果Tab. 1 Ablation experimental results of LGFFM, CA and Lossaux (%) |

| 方法 | OA | F1 | mIoU |

|---|---|---|---|

| Baseline | 96.33 | 93.02 | 91.05 |

| Net + LGFFM | 97.19 | 93.89 | 92.77 |

| Net + CA | 96.97 | 93.44 | 92.14 |

| Net + Lossaux | 97.04 | 92.93 | 91.56 |

| Net + LGFFM + CA | 97.42 | 94.94 | 93.61 |

| Net + CA + Lossaux | 97.07 | 93.74 | 92.69 |

| Net + LGFFM + Lossaux | 97.21 | 94.52 | 93.31 |

| Net + LGFFM + CA + Lossaux (CNNAMNet) | 97.57 | 95.49 | 94.05 |

表2 不同网络模型的2D和2.5D数据树冠分割定量评价结果Tab. 2 Quantitative evaluation results of 2D and 2.5D data crown segmentation for different network models (%) |

| 方法 | 数据集 | OA | F1 | mIoU |

|---|---|---|---|---|

| 区域生长 | 2D | 80.11 | 77.12 | 74.94 |

| 分水岭算法 | 2D | 87.38 | 82.60 | 80.45 |

| FCN | 2D | 95.29 | 88.71 | 86.97 |

| 2.5D | 95.19 | 90.75 | 88.39 | |

| BiseNet-V2 | 2D | 95.45 | 89.13 | 87.40 |

| 2.5D | 95.64 | 91.23 | 89.21 | |

| PSPNet | 2D | 96.85 | 92.47 | 91.05 |

| 2.5D | 97.09 | 94.41 | 92.94 | |

| EfficientNet-V2 | 2D | 96.89 | 92.80 | 91.47 |

| 2.5D | 96.75 | 93.99 | 92.16 | |

| DANet | 2D | 96.90 | 92.57 | 91.17 |

| 2.5D | 97.15 | 94.73 | 93.08 | |

| DeepLab-V3 | 2D | 97.15 | 93.26 | 91.85 |

| 2.5D | 97.06 | 94.56 | 92.88 | |

| CSwin-Tiny | 2D | 97.08 | 93.29 | 91.96 |

| 2.5D | 97.26 | 94.35 | 92.95 | |

| CNNAMNet | 2D | 97.20 | 94.62 | 93.03 |

| 2.5D | 97.57 | 95.49 | 94.05 |

图12 CNNAMNet在不同背景下柑橘果树树冠分割结果对比注:红色椭圆表示着重分析的区域。 Fig. 12 Comparison of citrus tree canopy segmentation result under different backgrounds using CNNAMNet |

表3 CNNAMNet在不同区域和数据的树冠分割定量评价对比Tab. 3 Quantitative evaluation comparison results of canopy segmentation in different regions and data using CNNAMNet (%) |

| 研究区域 | 数据集 | OA | Precision | Recall | F1 | mIoU |

|---|---|---|---|---|---|---|

| 区域1 | 2D | 96.39 | 92.17 | 93.94 | 93.05 | 91.12 |

| 2.5D | 96.94 | 93.61 | 94.56 | 94.08 | 92.39 | |

| 区域2 | 2D | 97.92 | 91.01 | 91.42 | 91.22 | 90.88 |

| 2.5D | 98.27 | 90.95 | 93.05 | 91.99 | 91.62 |

表4 CNNAMNet与其他先进网络模型对比结果Tab. 4 Comparison between the CNNAMNet and other state-of-the-art networks (%) |

| 方法 | OA | Precision | Recall | F1 | mIoU |

|---|---|---|---|---|---|

| SegFormer | 97.28 | 92.18 | 94.99 | 93.56 | 92.26 |

| SETR_PUP | 93.59 | 87.36 | 89.00 | 88.17 | 85.22 |

| TransUNet | 97.07 | 94.12 | 95.03 | 94.57 | 92.89 |

| TransFuse | 96.95 | 93.82 | 94.89 | 94.36 | 92.62 |

| CCTNet | 97.26 | 92.10 | 94.95 | 93.51 | 92.20 |

| CNNAMNet | 97.57 | 94.97 | 96.02 | 95.49 | 94.05 |

| [1] |

|

| [2] |

郭昱杉, 刘庆生, 刘高焕, 等. 基于标记控制分水岭分割方法的高分辨率遥感影像单木树冠提取[J]. 地球信息科学学报, 2016, 18(9):1259-1266.

[

|

| [3] |

|

| [4] |

冯静静, 张晓丽, 刘会玲. 基于灰度梯度图像分割的单木树冠提取研究[J]. 北京林业大学学报, 2017, 39(3):16-23.

[

|

| [5] |

|

| [6] |

徐伟萌, 杨浩, 李振洪, 等. 利用无人机数码影像进行密植型果园单木分割[J]. 武汉大学学报·信息科学版, 2022, 47(11):1906-1916.

[

|

| [7] |

|

| [8] |

|

| [9] |

张先洁, 孙国祥, 汪小旵, 等. 基于超像素特征向量的果树冠层分割方法[J]. 江苏农业学报, 2021, 37(3):724-730.

[

|

| [10] |

甄贞, 李响, 修思玉, 等. 基于标记控制区域生长法的单木树冠提取[J]. 东北林业大学学报, 2016, 44(10):22-29.

[

|

| [11] |

|

| [12] |

林禹, 赵泉华, 李玉. 一种基于深度传递迁移学习的遥感影像分类方法[J]. 地球信息科学学报, 2022, 24(3):495-507.

[

|

| [13] |

衡雪彪, 许捍卫, 唐璐, 等. 基于改进全卷积神经网络模型的土地覆盖分类方法研究[J]. 地球信息科学学报, 2023, 25(3):495-509.

[

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

刘浩, 骆剑承, 黄波, 等. 基于特征压缩激活Unet网络的建筑物提取[J]. 地球信息科学学报, 2019, 21(11):1779-1789.

[

|

/

| 〈 |

|

〉 |