室内视角下减弱点云空洞影响的三维可视性分析方法

|

陈茂霖(1991— ),男,山东德州人,博士,副教授,硕士生导师。研究方向为三维激光点云处理。E-mail: maolinchen@cqjtu.edu.cn |

Editor: 蒋树芳

收稿日期: 2024-05-27

修回日期: 2024-07-28

网络出版日期: 2024-09-10

基金资助

宁夏回族自治区重点研发计划(2022CMG02014)

重庆市研究生联合培养基地建设项目(JDLHPYJD2019004)

重庆市自然科学基金(CSTB2024NSCQ-MSX0652)

A 3D Visibility Analysis Method for Reducing the Influence of Point Cloud Voids from an Indoor Perspective

Received date: 2024-05-27

Revised date: 2024-07-28

Online published: 2024-09-10

Supported by

Key R&D Program of Ningxia Autonomous Region(2022CMG02014)

Graduate Joint Training Base Construction Project of Chongqing(JDLHPYJD2019004)

Natural Science Foundation of Chongqing(CSTB2024NSCQ-MSX0652)

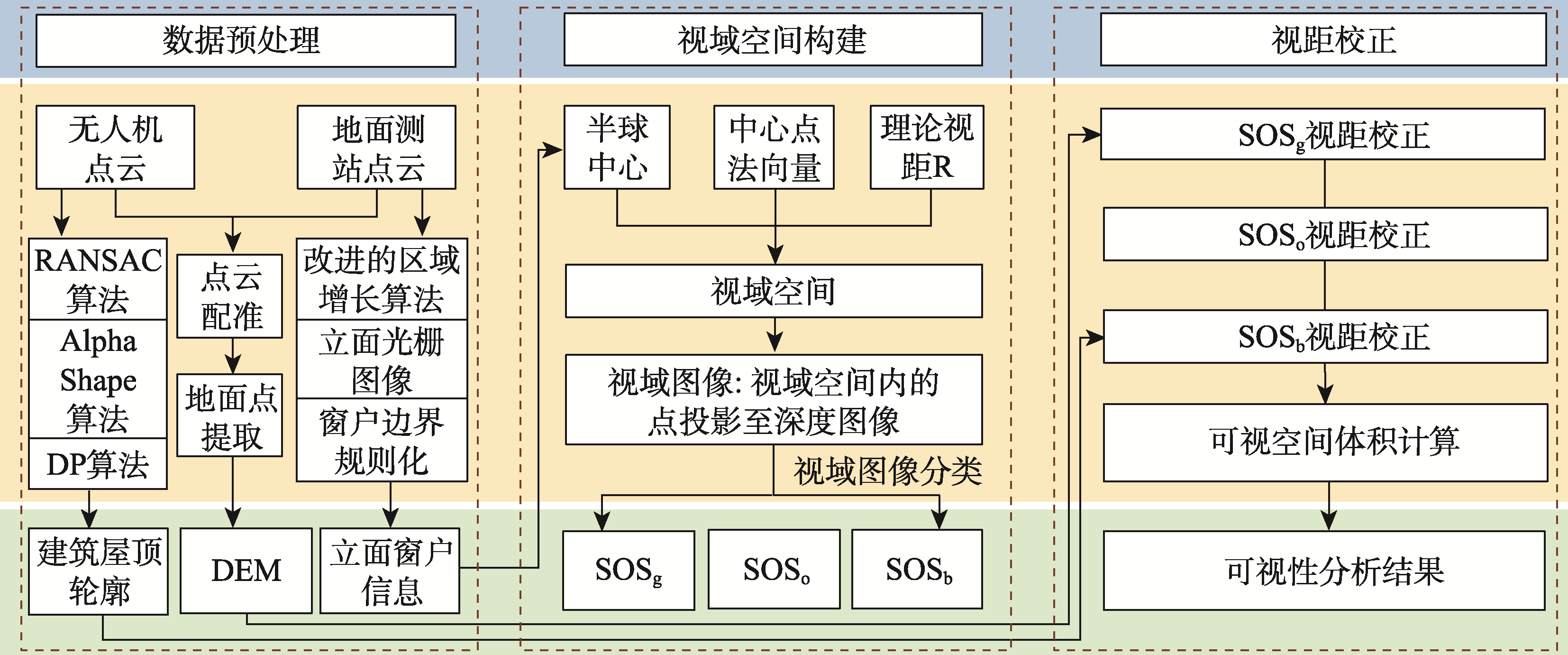

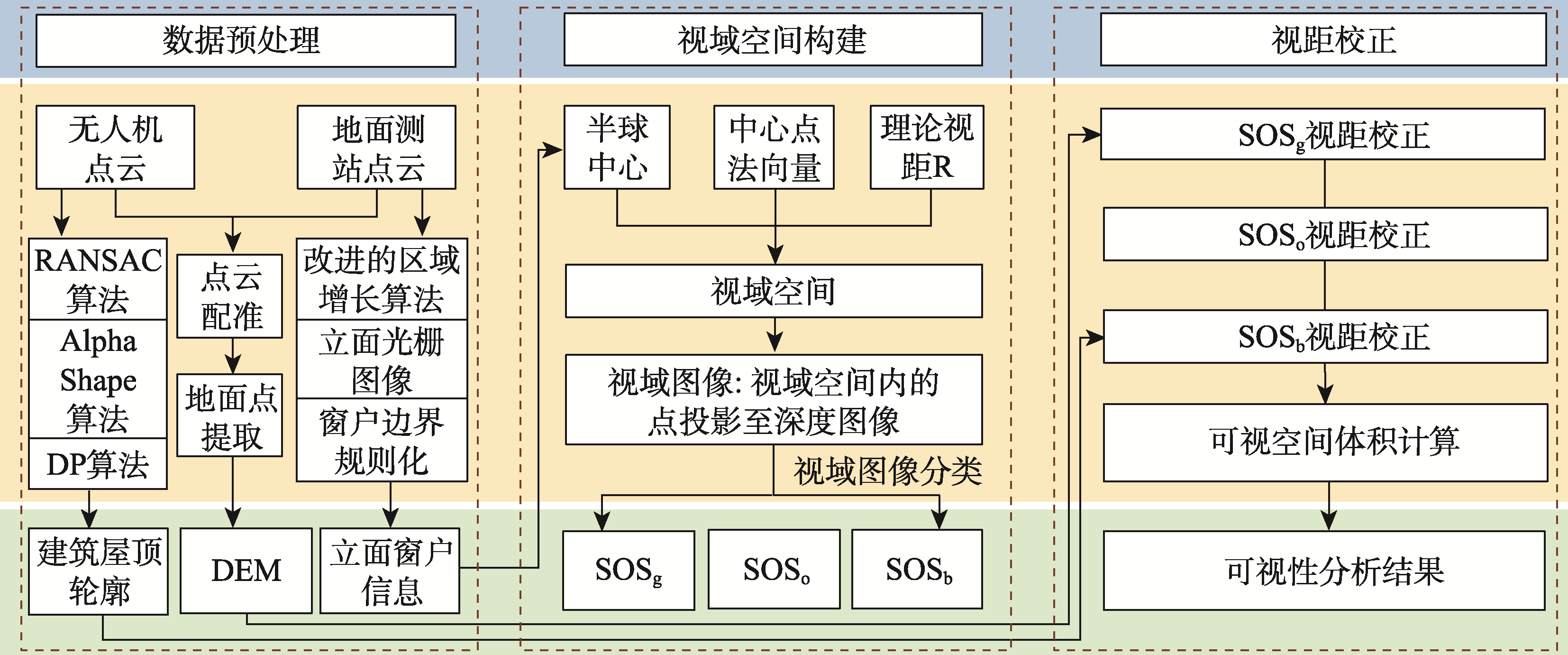

可视性是指在一定环境条件下,观察者从特定位置所能看到的空间范围。针对现有基于点云数据的可视性分析方法主要聚焦于室外视角,同时未充分考虑点云空洞的问题,提出一种减弱点云空洞影响的室内视角可视性分析方法。首先,将预处理得到的窗户中心点看作视点,以视点为中心,理论视距为半径,构建半球形视域空间。然后将视域空间内的点投影至深度图像形成视域图像,其像素深度值即为可视视距。通过分析视域空间的可视范围,模拟室内通过窗户观测到的外部场景。在这个过程中,点云空洞会造成视距错误,利用空间属性对视域空间分类,并根据不同类别视域空间的地物连续性和遮挡关系提出视距校正方法,以减弱点云空洞对可视空间体积的影响。最后,利用视点处的可视空间体积指数进行可视性分析,并与现有基于体素、基于表面的可视性分析方法以及人工评价进行比较。结果表明,本方法与人工评价的结果具有更好的一致性,能够更有效地分析建筑内部的可视性,为城市规划、景观设计等相关领域提供了一种全面可靠的可视性分析策略。

陈茂霖 , 朱飞宇 , 安奥博 , 潘建平 . 室内视角下减弱点云空洞影响的三维可视性分析方法[J]. 地球信息科学学报, 2024 , 26(9) : 2052 -2063 . DOI: 10.12082/dqxxkx.2024.240296

Visibility refers to the spatial extent that an observer can see from a specific location under certain environmental conditions. Existing visibility analysis methods, based on point cloud data, mainly focus on the outdoor perspective and do not fully consider the problem of point cloud voids. To fill the gaps in the current indoor visibility research, this paper proposes an indoor 3D visibility analysis method based on point cloud data from UAVs and ground survey data. Our method reduces the influence of point cloud voids and aims to improve the accuracy of the visibility analysis. The method presented in this paper is divided into three parts: data preprocessing, visual space construction, and visual distance correction. In the data preprocessing stage, UAV point cloud data is used to extract the building roof contour and DEM, which are utilized for subsequent visual distance correction. Ground-based point cloud data is then used to extract the center points of the windows on the building façade, which serve as observation viewpoints. In the viewspace construction stage, the viewpoint is taken as the center, and the theoretical visual distance is taken as the radius. Points within the theoretical visual distance are selected to construct a hemispherical viewspace. The points in the visual field space are projected onto the depth image to form the visual field image. The visual field of view is then calculated, and the visual range of the field of view space is analyzed to simulate the external scene observed through the window in the room. During this process, point cloud voids can lead to errors in the visual range. Specifically, when the positions of the scanning center and the viewpoint differ significantly, missing parts may appear in the visible space, and the pass-through errors may also occur near the viewpoint due to insufficient point cloud density. In the sight distance correction stage, this paper categorizes the viewspace using spatial attributes and proposes a sight distance correction method to attenuate the effect of point cloud voids on the volume of the visible space by considering the feature continuity and occlusion relationship within different categories of the viewspace. Finally, visibility analysis is conducted using the visual space volume index at the viewpoint and is compared with the existing voxel-based and surface-based visibility analysis methods, as well as a manual evaluation. The DTW distances for comparisons are 48 247, and 240, respectively. The results show that the proposed method has better consistency with manual evaluation results. It can analyze the visibility of indoor environments more effectively, and is also applicable to outdoor visibility analysis. This method provides a comprehensive and reliable visibility analysis strategy for urban planning, landscape design, and other related fields.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

齐君, 白钊成, 吕光耀, 等. 基于人眼视域图像识别的风景道视觉景观质量评价[J]. 地理学报, 2022, 77(11):2817-2837.

[

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

贺文慧, 杨昕, 汤国安, 等. 基于数字高程模型的城市地表开阔度研究——以南京老城区为例[J]. 地球信息科学学报, 2012, 14(1):94-100.

[

|

| [11] |

|

| [12] |

钮心毅, 徐方. 基于视觉影响的建成环境空间开敞度定量评价方法[J]. 城市规划学刊, 2011(1):91-97.

[

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

米晓新, 杨必胜, 董震. 车载激光点云道路场景可视域快速计算与应用[J]. 武汉大学学报(信息科学版), 2020, 45(2):258-264.

[

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

安奥博, 陈茂霖, 赵立都, 等. 长测距地基点云密度自适应平面分割算法[J]. 激光技术, 2023, 47(5):606-612.

[

|

| [29] |

|

| [30] |

杨俊宴, 马奔. 城市天空可视域的测度技术与类型解析[J]. 城市规划, 2015, 39(3):54-58.

[

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

/

| 〈 |

|

〉 |