采用Line-CNN深度学习网络的机载点云建筑轮廓线提取

|

黄奕舒(2001— ),女,江苏常州人,本科,主要从事激光点云智能处理研究。E-mail: m19825039060@163.com |

Editor: 蒋树芳

收稿日期: 2023-08-29

修回日期: 2023-10-24

网络出版日期: 2024-09-10

基金资助

国家自然科学基金面上项目(42171433)

国家自然青年科学基金项目(41701529)

Extraction of Building Outlines from Airborne LiDAR Point Clouds Using Line-CNN Based on Deep Network

Received date: 2023-08-29

Revised date: 2023-10-24

Online published: 2024-09-10

Supported by

Geneal Program of National Natural Science Foundation of China(42171433)

National Natural Science Foundation of China(41701529)

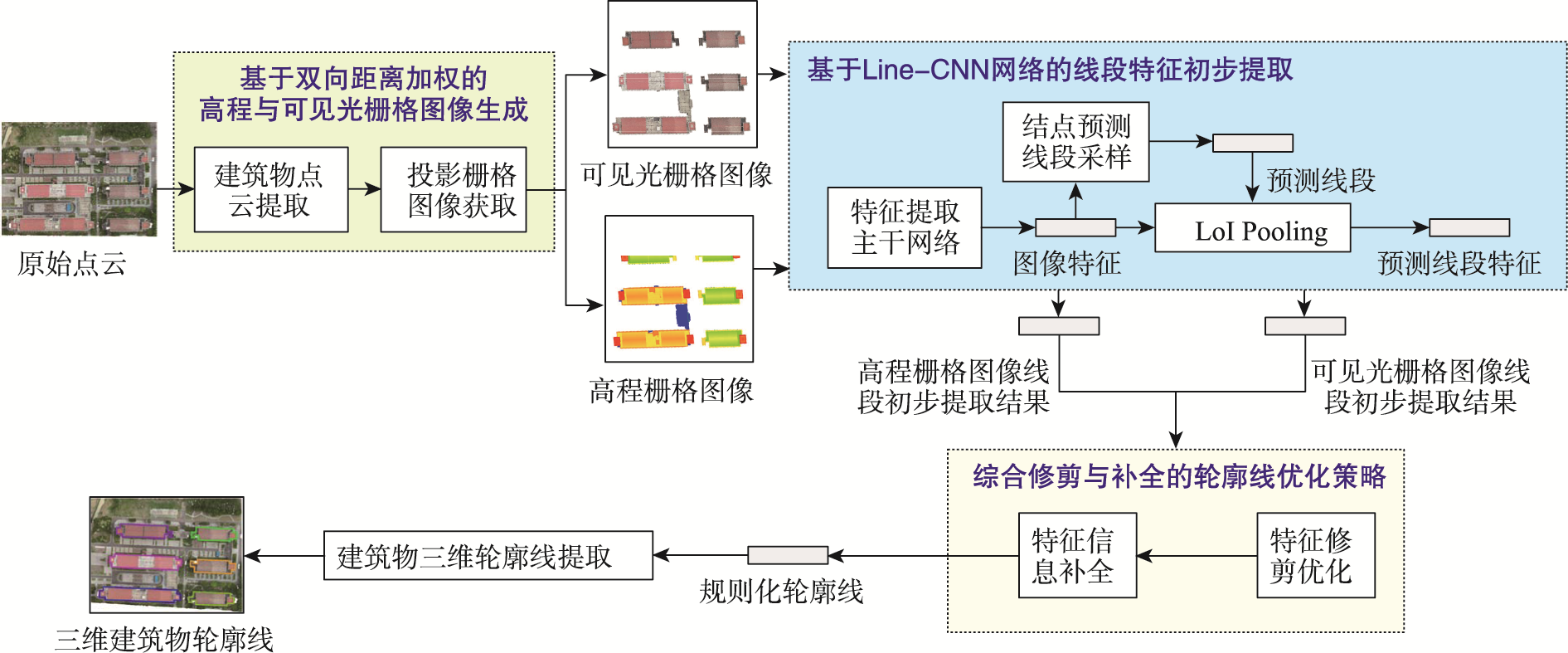

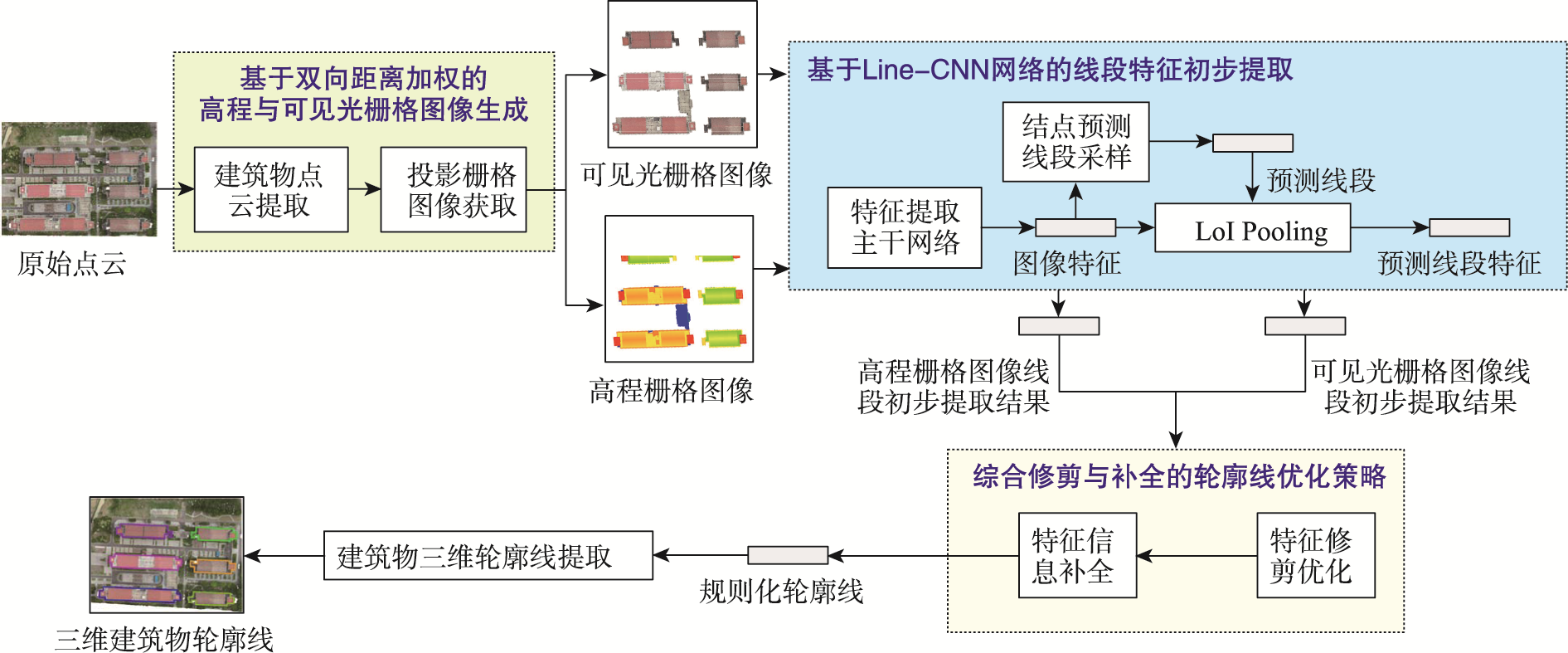

城市三维模型是数字孪生、智慧城市建设的重要载体,实现建筑轮廓线的有效提取是城市高精度建模和三维测图的关键步骤。针对现有建筑物轮廓线提取效率与准确度较低的问题,本文提出了一种基于彩色机载点云的建筑轮廓线深度学习提取方法。首先,通过垂直投影,由经过渐进形态学滤波后的建筑物彩色机载点云,分别生成描述建筑物空间信息的高程栅格图像与反映其纹理差异的可见光栅格图像;然后,利用Line-CNN深度学习网络,经过特征提取、结点预测、路线生成等过程,从栅格图像中初步提取出线段特征;最后,为有效提取轮廓线特征,提出了一套综合修剪与补全操作的优化策略,并结合高程和可见光栅格图像中的优化线段信息,获得规则且完整的建筑物轮廓线特征。经过对南京信息工程大学的机载点云数据以及ISPRS H3D 2019数据集的实验证明,该方法对机载点云建筑物轮廓线提取有效,避免了因三维点云深度学习中标定样本不足而无法直接提取的问题;能准确、完整地提取出场景中建筑物的轮廓线特征,平均准确度与完整度均高达90%,且算法较为高效,有利于大范围城市三维建模与地籍测量等相关应用。

黄奕舒 , 臧玉府 , 蒋其含 , 米文瀚 . 采用Line-CNN深度学习网络的机载点云建筑轮廓线提取[J]. 地球信息科学学报, 2024 , 26(9) : 2161 -2176 . DOI: 10.12082/dqxxkx.2024.230503

Urban 3D modeling is indispensable for digital twinning and the development of smart cities. The effective extraction of building outlines is a critical step in achieving high-precision urban modeling and 3D mapping. At present, the extraction of building outlines from airborne point cloud data still faces challenges, such as low efficiency and accuracy with conventional methods and limited calibration samples. In response to these challenges, this paper introduces a deep learning method for extracting building outlines from 3D airborne point clouds. The airborne LiDAR point clouds are the primary data input. First, through vertical projection to the XOY plane, point clouds of buildings with the application of progressive morphological filtering are converted to rasterized elevation that characterizes spatial variation of terrain and visible light raster images that depict texture differences. Then, the deep learning model based on Lines-Convolutional Neural Networks (Line-CNN) is employed to preliminarily extract line features from raster images, encompassing stages of feature extraction, node prediction, route generation, and others. To enhance the quality of the primary straight-line extraction, an optimization strategy is introduced, which incorporates a range of comprehensive trimming and completion operations, aligning with information extracted from both the elevation and visible light raster images. Simultaneously, false line segments are eliminated, and missing lines are added, resulting in the regular and complete building outline features. To verify the proposed model, the airborne point cloud data from NUIST campus and the ISPRS H3D 2019 datasets are utilized in the experiment. Our results show that the proposed method accurately and comprehensively extracts building outline features from LiDAR images, achieving an impressive average accuracy and completeness rate, both up to 90%. Furthermore, the proposed method is highly efficient and effectively addresses the challenge of insufficient 3D calibration samples in traditional methods, making it suitable for various applications, particularly large-scale urban 3D modeling and cadastral surveying. To sum up, the proposed method constitutes a significant stride in advancing urban modeling and 3D mapping. It provides a novel solution to address the challenges associated with building outline extraction, particularly within the context of smart cities and digital twins. Due to the model's high accuracy, completeness, and efficiency, our method is highly helpful for a wide range of applications in the urban planning and geospatial information fields.

| [1] |

杨必胜, 梁福逊, 黄荣刚. 三维激光扫描点云数据处理研究进展、挑战与趋势[J]. 测绘学报, 2017, 46(10):1509-1516..

[

|

| [2] |

霍芃芃, 侯妙乐, 杨溯, 等. 机载LiDAR点云建筑物屋顶轮廓线自动提取研究综述[J]. 地理信息世界, 2019, 26(5):1-13..

[

|

| [3] |

赖旭东, 万幼川. 机载激光雷达距离图像的边缘检测研究[J]. 激光与红外, 2005, 35(6):444-446..

[

|

| [4] |

|

| [5] |

|

| [6] |

李云帆, 谭德宝, 高广, 等. 双阈值Alpha Shapes算法提取点云建筑物轮廓研究[J]. 长江科学院院报, 2016, 33(11):1-4..

[

|

| [7] |

李世林, 李红军. 自适应步长的Alpha-shape表面重建算法[J]. 数据采集与处理, 2019, 34(3):491-499..

[

|

| [8] |

赵传. 基于机载LiDAR点云数据的建筑物三维模型重建技术研究[D]. 郑州: 解放军信息工程大学, 2017..

[

|

| [9] |

朱军桃, 王雷, 赵苗兴, 等. 基于机载LiDAR数据的建筑物屋顶边界提取[J]. 桂林理工大学学报, 2019, 39(4):879-885..

[

|

| [10] |

周维娜, 程晓光, 严明, 等. 机载LiDAR点云中静态水体边界提取[J]. 遥感信息, 2021, 36(3):32-38..

[

|

| [11] |

戴腾, 王金龙, 周锋, 等. 基于LiDAR数据的水域边界提取方法探讨[J]. 地理空间信息, 2022, 20(4):87-90.

[

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

魏亚, 肖庸, 闫闯, 等. 基于点云预处理的路面三维重构数据优化[J]. 吉林大学学报(工学版), 2020, 50(3):987-997..

[

|

/

| 〈 |

|

〉 |