Journal of Geo-information Science >

A Method for Building Extraction by Fusing Feature Information from LiDAR Data and High-Resolution Imagery

Received date: 2019-08-26

Request revised date: 2019-10-17

Online published: 2020-10-25

Supported by

National Natural Science Founda- tion of China(41701491)

National Natural Science Foundation of Fujian province(2017J01464)

National Natural Science Foundation of China(41801324)

National Natural Science Foundation of Fujian province(2019J01244)

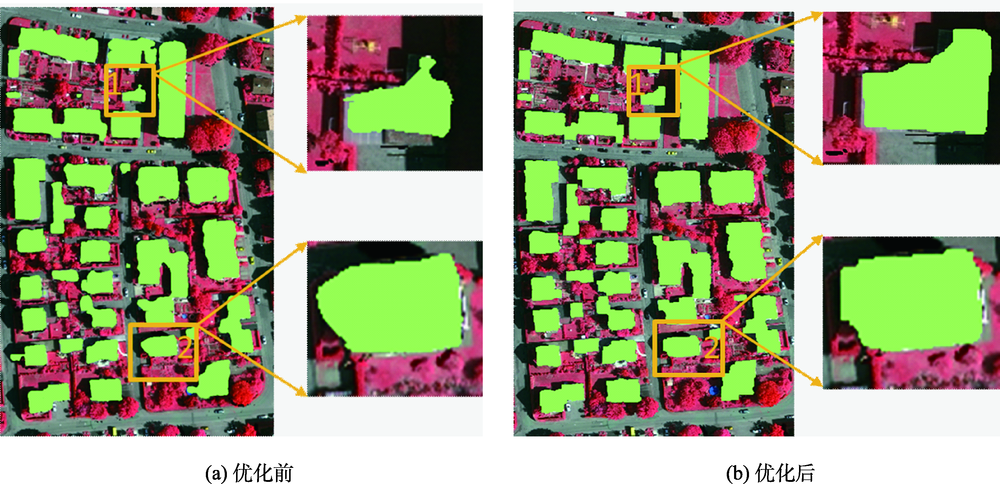

Copyright

One of the main feature types in urban areas is building; automatic building extraction from high-resolution imagery or other data has great significance for improving the quality and efficiency of land use change detection, urban planning, land law enforcement, and so on. To deal with the problem of boundary inaccuracy of extracted buildings and the limitation caused by expressing image information with artificial features, this paper proposed a new building extraction method based on the SegNet semantic model, which fused feature information from LiDAR data and high-resolution imagery. Firstly, LiDAR data were preprocessed to obtain Digital Surface Model (DSM), Digital Terrain Model (DTM), and normalized Digital Surface Model (nDSM). The resulted image nDSM_en was acquired by removing tree points from nDSM with Normalized Differential Vegetation Index (NDVI) values derived from high-resolution imagery. Secondly, three features–LiDAR data echo intensity, and surface curvature from LiDAR data, and NDVI from high-resolution imagery were obtained to construct feature images for training the SegNet semantic model. Initial extraction of buildings was completed with the trained model. Finally, the threshold segmentation algorithm was executed with nDSM_en for generating image objects, which were used to refine the initially extracted buildings through boundary constraints. In the experiment which utilized the Standard Dataset as a sample, the average completeness, correctness, and extract quality of the proposed method at the pixel level were 96.4%, 94.8%, and 91.7% respectively. For building objects with area larger than 50 m 2, the above three indicators were 100%. Our findings suggest that the proposed building extraction method makes better use of the feature information which reflects the essential difference between buildings and non-buildings, integrates effectively the relative advantages of the two data sources, and can increase the accuracy of building detection and extraction.Key words: building extraction; LiDAR data; high resolution image; SegNet; threshold segmentation; boundary constraint

GUO Feng , MAO Zhengyuan , ZOU Weibin , WENG Qian . A Method for Building Extraction by Fusing Feature Information from LiDAR Data and High-Resolution Imagery[J]. Journal of Geo-information Science, 2020 , 22(8) : 1654 -1665 . DOI: 10.12082/dqxxkx.2020.190459

表1 分类结果混淆矩阵Tab. 1 Confusion matrix of classification results |

| 真实情况 | 预测结果 | |

|---|---|---|

| 正例 | 反例 | |

| 正例 | TP(真正例) | FN(假反例) |

| 反例 | FP(假正例) | TN(真反例) |

表2 建筑物提取精度评价Tab. 2 Accuracy evaluation of building extraction (%) |

| 测试 数据 | per-area 基于像素 | per-object 基于对象 | per-object(>50 m2) 基于对象(>50 m2) | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 查全率 | 查准率 | 质量 | 查全率 | 查准率 | 质量 | 查全率 | 查准率 | 质量 | |||

| 区域一 | 95.8 | 94.1 | 90.9 | 86.0 | 100.0 | 86.0 | 100.0 | 100.0 | 100.0 | ||

| 区域二 | 96.6 | 95.3 | 91.7 | 85.7 | 100.0 | 85.7 | 100.0 | 100.0 | 100.0 | ||

| 区域三 | 96.9 | 95.1 | 92.6 | 83.3 | 100.0 | 83.3 | 100.0 | 100.0 | 100.0 | ||

| 平均值 | 96.4 | 94.8 | 91.7 | 85.0 | 100.0 | 85.0 | 100.0 | 100.0 | 100.0 | ||

表3 本文方法与ISPRS网站其它方法对比Tab. 3 Comparison between the proposed method and methods in the ISPRS website (%) |

| 研究 方法 | per-area 基于像素 | per-object 基于对象 | per-object(>50 m2) 基于对象(>50 m2) | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 查全率 | 查准率 | 质量 | 查全率 | 查准率 | 质量 | 查全率 | 查准率 | 质量 | |||

| CAL1 | 89.8 | 95.1 | 85.8 | 76.2 | 100.0 | 76.2 | 96.5 | 100.0 | 96.5 | ||

| CAL2 | 89.2 | 97.2 | 87.2 | 78.2 | 100.0 | 78.2 | 100.0 | 100.0 | 100.0 | ||

| LJU1 | 94.2 | 94.6 | 89.4 | 83.0 | 100.0 | 83.0 | 100.0 | 100.0 | 100.0 | ||

| LJU2 | 94.6 | 94.4 | 89.5 | 87.9 | 100.0 | 87.9 | 100.0 | 100.0 | 100.0 | ||

| TUM | 89.7 | 92.9 | 83.9 | 80.9 | 99.0 | 80.2 | 99.1 | 100.0 | 99.1 | ||

| HAND | 93.6 | 90.3 | 85.0 | 80.3 | 88.8 | 73.0 | 97.4 | 97.2 | 94.6 | ||

| RMA | 92.8 | 90.2 | 84.2 | 82.7 | 81.0 | 68.1 | 100.0 | 100.0 | 100.0 | ||

| ZJU | 92.8 | 96.4 | 89.7 | 76.4 | 97.0 | 74.8 | 99.1 | 100.0 | 99.1 | ||

| SZU | 94.9 | 89.5 | 85.4 | 91.1 | 71.8 | 67.7 | 100.0 | 97.2 | 97.2 | ||

| MON3 | 94.8 | 83.9 | 80.2 | 83.0 | 97.5 | 81.4 | 99.1 | 100.0 | 99.1 | ||

| MON4 | 94.3 | 82.9 | 85.6 | 83.9 | 93.8 | 80.0 | 99.1 | 100.0 | 99.1 | ||

| MON5 | 89.9 | 90.3 | 82.0 | 87.2 | 96.3 | 84 | 99.1 | 100.0 | 99.1 | ||

| WHU_YD | 89.8 | 98.6 | 89.3 | 87.8 | 99.3 | 87.0 | 99.1 | 100.0 | 99.1 | ||

| CSU | 94.0 | 94.9 | 90.9 | 83.3 | 97.2 | 82.0 | 100.0 | 100.0 | 100.0 | ||

| HKP | 91.4 | 97.8 | 90.9 | 79.7 | 96.5 | 77.5 | 99.3 | 100.0 | 99.3 | ||

| 本文方法 | 96.4 | 94.8 | 91.7 | 85.0 | 100.0 | 85.0 | 100.0 | 100.0 | 100.0 | ||

注:所有评价指标均取3个研究区域的平均值,其中加粗的数值为该列评价指标的最佳值。 |

| [1] |

|

| [2] |

|

| [3] |

施文灶, 毛政元. 基于图分割的高分辨率遥感影像建筑物变化检测研究[J]. 地球信息科学学报, 2016,18(3):423-432.

[

|

| [4] |

|

| [5] |

|

| [6] |

刘文涛, 李世华, 覃驭楚. 基于全卷积神经网络的建筑物屋顶自动提取[J]. 地球信息科学学报, 2018,20(11):1562-1570.

[

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

何曼芸, 程英蕾, 邱浪波, 等. 一种改进顶帽变换与LBP高程纹理的城区建筑物提取算法[J]. 测绘学报, 2017,46(9):1116-1112.

[

|

| [15] |

|

| [16] |

|

| [17] |

程亮, 龚健雅. LiDAR辅助下利用超高分辨率影像提取建筑物轮廓方法[J]. 测绘学报, 2008,37(3):391-393.

[

|

| [18] |

杜守基, 邹峥嵘, 张云生, 等. 融合LiDAR点云与正射影像的建筑物图割优化提取方法[J]. 测绘学报, 2018,47(4):519-527.

[

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

崔建军, 隋立春, 徐花芝, 等. 基于边缘检测算法的LiDAR数据建筑物提取[J]. 测绘科学技术学报, 2008(2):98-100.

[

|

| [23] |

王金霞, 窦爱霞, 王晓青, 等. 地震后机载LiDAR点云的地物区分方法研究[J]. 震灾防御技术, 2017,12(3):677-689.

[

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

/

| 〈 |

|

〉 |