Journal of Geo-information Science >

Building Extraction by Deep Learning Method Combined with Ambiguity and Morphological Index Constraints

Received date: 2020-07-26

Request revised date: 2020-11-23

Online published: 2021-07-25

Supported by

National Key Research and Development Project(2018YFB0505000)

National Key Research and Development Project(2017YFB0504204)

National Key Research and Development Project(2016YFC0803109)

National Natural Science Foundation of China(41971375)

National Natural Science Foundation of China(41871283)

Copyright

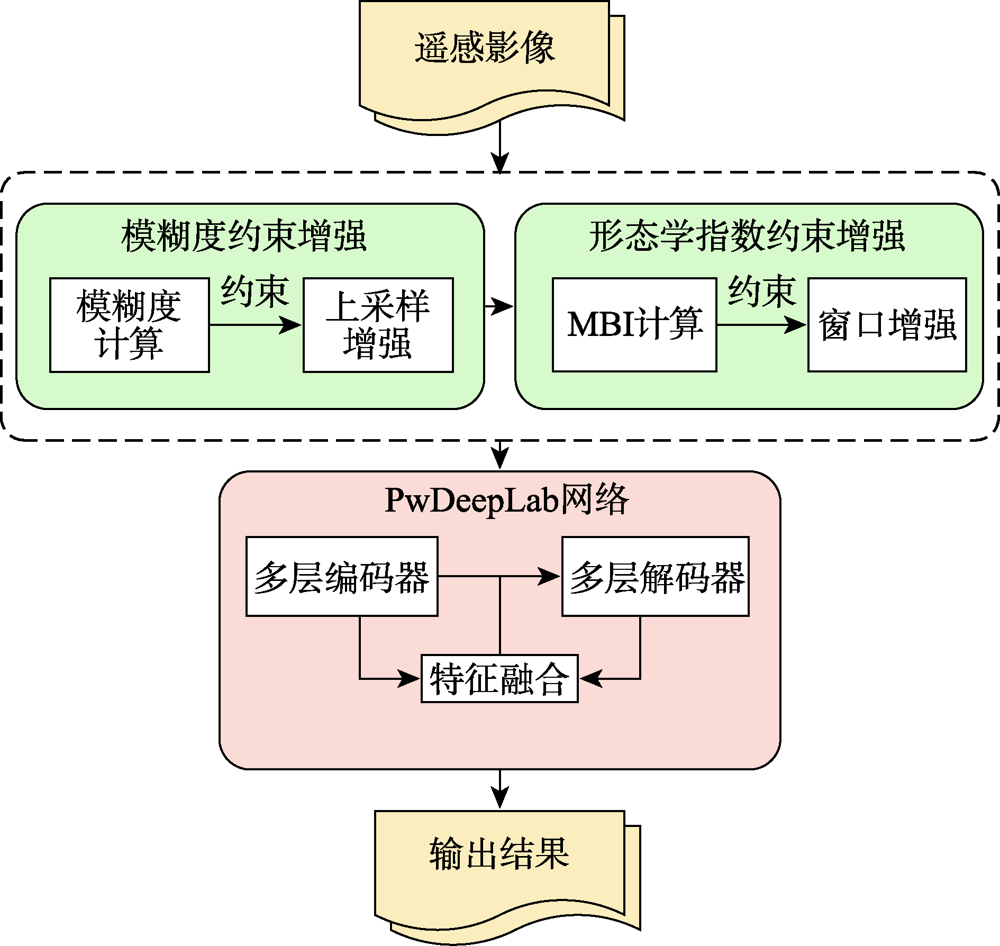

Extraction of buildings from high-resolution remote sensing images has been a hot topic. It is important to quickly and accurately extract the location and outline of buildings from high-resolution remote sensing images for earthquake disaster assessment, urban and rural planning management, smart city construction, and other fields. However, it is challenging to extract buildings accurately from high-resolution remote sensing images due to the complexity of ground features and the occlusion phenomenon. The classic building extraction algorithms usually have incomplete results with many wrong detections and missed detections. The deep-level feature extraction method of deep learning is very suitable for the extraction of buildings from high-resolution images. However, for the existing researches using deep learning algorithms, most algorithms are optimized by changing the network structure and are rarely combined with other methods. The pertinence of building extraction is not strong. This paper not only studies the influence of the internal structure of the convolutional neural network in deep learning on the extraction results, but also studies the combination of ambiguity, Morphological Building Index (MBI) with deep learning. The main improvements in this paper are as follows: (1) Based on the DeepLab v3+ network structure, we propose the PwDeepLab network which improves feature fusion methods and loss functions; (2) We propose a blur degree constraint method. We define a new blur degree formula to evaluate the image blur degree. In the case of a fixed image block size, the image is upsampled and enhanced by the image blur degree constraint; (3) We propose a morphological index constraint method. The pixels of the original image are stretched and enhanced where the Morphological Building Index (MBI) is above the threshold. Therefore, the building information can be highlighted with less changes to the original image characteristics. Our method is verified using the Massachusetts dataset and the satellite dataset II (East Asia) of Wuhan University. The main building types of the two datasets are quite different. As a result, the accuracy of the proposed method on the two datasets increases by 10.9% and 3.8%, respectively, compared with DeepLab v3+, and increases by 10.0% and 9.6%, respectively, compared with U-Net. The higher accuracy reflects the superiority and robustness of our method. Moreover, the extracted results match the real labels very well in details. The experimental results show that the method proposed in this paper can significantly improve the building extraction results.

XU Zeyu , SHEN Zhanfeng , LI Yang , KE Yingming , LI Shuo , WANG Haoyu , JIAO Shuhui . Building Extraction by Deep Learning Method Combined with Ambiguity and Morphological Index Constraints[J]. Journal of Geo-information Science, 2021 , 23(5) : 918 -927 . DOI: 10.12082/dqxxkx.2021.200397

表1 Massachusetts数据集各算法提取精度Tab. 1 The extraction accuracy of each method on Massachusetts dataset |

| 精确度 | 召回率 | F1 | 等值点 | |

|---|---|---|---|---|

| U-Net | 0.7455 | 0.7988 | 0.7712 | 0.7712 |

| DeepLab v3+ | 0.7826 | 0.7417 | 0.7616 | 0.7649 |

| PwDeepLab | 0.7853 | 0.7783 | 0.7818 | 0.7821 |

| PwDeepLab.A | 0.8271 | 0.8414 | 0.8342 | 0.8339 |

| PwDeepLab.A.M | 0.8459 | 0.8513 | 0.8486 | 0.8483 |

注:红色加粗数值为各列最优值。 |

表2 Satellite dataset Ⅱ(East Asia)各方法提取精度Tab. 2 The extraction accuracy of each method on Satellite dataset Ⅱ (East Asia) dataset |

| 精确度 | 召回率 | F1 | 等值点 | |

|---|---|---|---|---|

| U-Net | 0.7584 | 0.7377 | 0.7479 | 0.7490 |

| DeepLab v3+ | 0.7848 | 0.7969 | 0.7908 | 0.7907 |

| PwDeepLab | 0.8247 | 0.8072 | 0.8159 | 0.8168 |

| PwDeepLab.A | 0.8285 | 0.8062 | 0.8172 | 0.8175 |

| PwDeepLab.A.M | 0.8224 | 0.8198 | 0.8211 | 0.8209 |

注:红色加粗值为各列最优值。 |

| [1] |

龚健雅, 季顺平. 摄影测量与深度学习[J]. 测绘学报, 2018,47(6):693-704.

[

|

| [2] |

李军军, 曹建农, 朱莹莹 等. 高分辨率遥感影像建筑区域局部几何特征提取[J]. 遥感学报, 2020,24(3):233-244.

[

|

| [3] |

|

| [4] |

张浩, 赵云胜, 陈冠宇, 等. 基于支持向量机的遥感图像建筑物识别与分类方法研究[J]. 地质科技情报, 2016,35(6):194-199.

[

|

| [5] |

杨山. 发达地区城乡聚落形态的信息提取与分形研究——以无锡市为例[J]. 地理学报, 2000,55(6):671-678.

[

|

| [6] |

查勇, 倪绍祥, 杨山. 一种利用TM图像自动提取城镇用地信息的有效方法[J]. 遥感学报, 2003,7(1):37-40.

[

|

| [7] |

|

| [8] |

陈志强, 陈健飞. 基于NDBI指数法的城镇用地影像识别分析与制图[J]. 地球信息科学, 2006,8(2):137-140.

[

|

| [9] |

杨智翔, 何秀凤. 基于改进的NDBI指数法的遥感影像城镇用地信息自动提取[J]. 河海大学学报(自然科学版), 2010,38(2):181-184.

[

|

| [10] |

陈行, 卓莉, 陶海燕. 基于MMBI的高分辨率影像建筑物提取研究[J]. 遥感技术与应用, 2016,31(5):930-938.

[

|

| [11] |

贺晓璐, 刘振华, 胡月明. 基于面向对象的建筑物信息提取方法研究[J]. 河南理工大学学报(自然科学版), 2020,39(2):53-61.

[

|

| [12] |

游永发, 王思远, 王斌 等. 高分辨率遥感影像建筑物分级提取[J]. 遥感学报, 2019,23(1):125-136.

[

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

朱光亚. 基于深度学习的遥感影像建筑物提取方法研究[D]. 杭州:浙江大学, 2019.

[

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

/

| 〈 |

|

〉 |