Journal of Geo-information Science >

A Dense Matching Algorithm for Remote Sensing Images based on Reliable Matched Points Constraint

Received date: 2020-11-03

Request revised date: 2021-01-28

Online published: 2021-10-25

Supported by

National Natural Science Foundation of China(41871379)

National Natural Science Foundation of China(42071343)

Liaoning Revitalization Talents Program(XLYC2007026)

Copyright

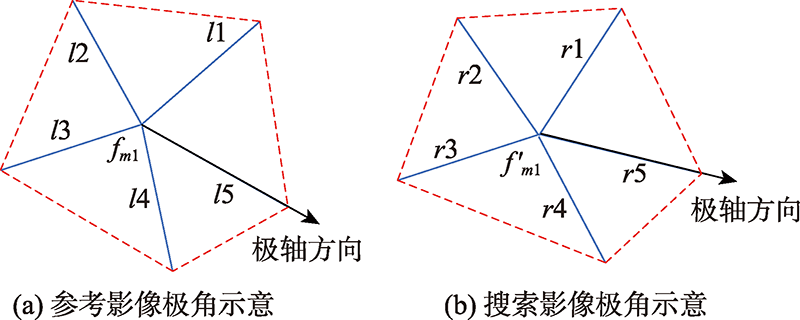

To avoid the problem of mismatches caused by initial matched points that may contain false matches during iterative dense matching based on corresponding points, a dense matching algorithm for remote sensing images based on reliable matched point constraint is presented. Firstly, to increase the number of initial matching points and expand the covering range of initial matching points, the initial set of matched points containing the matched Scale-invariant Feature Transform (SIFT) points and virtual corresponding points is constructed, where the virtual corresponding points are generated from the intersections of corresponding lines obtained by the line matching algorithm based on the matched SIFT points constraint. Secondly, the initial set of matched points is checked to remove the false matches using local image information and local geometry constraints in turn. This process first uses the local texture feature constraint constructed based on fingerprint information and gradient information to eliminate the mismatched points with low similarity, and then uses the local geometric constraint constructed by Delaunay triangulation to remove the false matches generated by similar textures, thereby obtaining the optimized set of reliable matched points. Finally, the Delaunay triangulation is constructed using reliable matched points, and the gravity center of the triangles satisfying the areal threshold is used as the matching primitive during the dense matching process. The matching based on the epipolar constraint and affine transformation constraint is performed iteratively to obtain the dense matching results. This paper used four sets of forward and backward viewing data of ZY-3 to perform parameter analysis experiment and comparative analysis experiment to prove the effectiveness of the proposed dense matching algorithm. The results of parameter analysis experiment show that the reliable matched points can be obtained when the weighted index, texture feature similarity threshold, and local geometric similarity threshold are 0.3, 0.95, and 0.85, respectively. The average matching accuracy of the reliable matched points on the four sets of data is improved by 19% compared with the initial matched point. Meanwhile, the results of comparative analysis experiment show that the dense matching algorithm based on the reliable matched point constraint can effectively avoid the error propagation, which has higher matching accuracy compared with the comparison algorithms selected in this paper. The average matching accuracy of the four sets of data is 95%. Therefore, the algorithm can obtain better dense matching results by effectively eliminating mismatched points.

ZHANG Xin , WANG Jingxue , LIU Suyan , GAO Song . A Dense Matching Algorithm for Remote Sensing Images based on Reliable Matched Points Constraint[J]. Journal of Geo-information Science, 2021 , 23(8) : 1508 -1523 . DOI: 10.12082/dqxxkx.2021.200660

表2 不同阈值下纹理特征约束参数分析表Tab. 2 Texture feature constraint parameter analysis table under different thresholds |

| Tgh | λ=0.1 | λ=0.2 | λ=0.3 | λ=0.4 | λ=0.5 | ||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Imatch/对 | Icor/对 | Iacc | Imatch/对 | Icor/对 | Iacc | Imatch/对 | Icor/对 | Iacc | Imatch/对 | Icor/对 | Iacc | Imatch/对 | Icor/对 | Iacc | |||||

| 0.75 | 2591 | 133 | 0.05 | 2592 | 240 | 0.09 | 2591 | 305 | 0.11 | 2591 | 99 | 0.03 | 2585 | 89 | 0.03 | ||||

| 0.80 | 2595 | 280 | 0.10 | 2596 | 444 | 0.17 | 2593 | 480 | 0.19 | 2587 | 219 | 0.08 | 2588 | 188 | 0.07 | ||||

| 0.85 | 2592 | 702 | 0.27 | 2592 | 753 | 0.29 | 2597 | 816 | 0.31 | 2590 | 534 | 0.20 | 2589 | 482 | 0.19 | ||||

| 0.90 | 2586 | 1786 | 0.69 | 2599 | 1996 | 0.76 | 2622 | 2170 | 0.80 | 2586 | 1691 | 0.65 | 2588 | 1609 | 0.62 | ||||

| 0.95 | 2374 | 2190 | 0.92 | 2379 | 2210 | 0.93 | 2367 | 2225 | 0.94 | 2398 | 2221 | 0.93 | 2449 | 2271 | 0.92 | ||||

图9 基于Delaunay三角网的局部几何特征约束参数分析Fig. 9 Analysis of local geometric feature constraint parameters based on Delaunay triangulation network |

表3 不同阈值下局部几何约束参数分析表Tab. 3 Analysis table of local geometric constraint parameters under different thresholds |

| Tgeo | λ=0.3,Tgh=0.95 | ||

|---|---|---|---|

| Imatch/对 | Icor/对 | Iacc | |

| 0.75 | 2463 | 2370 | 0.96 |

| 0.80 | 2451 | 2378 | 0.97 |

| 0.85 | 2438 | 2387 | 0.98 |

| 0.90 | 2344 | 2301 | 0.98 |

| 0.95 | 2231 | 2180 | 0.98 |

图10 初始匹配点Delaunay三角网Fig. 10 Initial matched points of Delaunay triangulation network |

图11 可靠匹配点Delaunay三角网Fig. 11 Reliable matched points of Delaunay triangulation network |

表4 初始匹配点和可靠匹配点对比Tab. 4 Comparison of initial matched points and reliable matched points |

| 数据 | 第1组 | 第2组 | 第3组 | 第4组 | |||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 初始匹配点 | 可靠匹配点 | 初始匹配点 | 可靠匹配点 | 初始匹配点 | 可靠匹配点 | 初始匹配点 | 可靠匹配点 | ||||

| Imatch /对 | 622 | 154 | 1943 | 382 | 712 | 176 | 224 | 121 | |||

| Icor /对 | 406 | 133 | 1534 | 379 | 547 | 173 | 190 | 116 | |||

| Iacc | 0.65 | 0.87 | 0.79 | 0.99 | 0.77 | 0.98 | 0.85 | 0.97 | |||

图12 不同算法不同阈值下加密匹配结果Fig. 12 Encryption matching results under different algorithms and different thresholds |

表5 不同算法在不同阈值下密集匹配结果比较Tab. 5 Comparison of dense matching results of different algorithms under different thresholds |

| T1 | 文献[30]算法 | r | 文献[33]算法 | Ts | 本文算法 | ||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| Imatch/对 | Icor/对 | Iacc | Imatch/对 | Icor/对 | Iacc | Imatch/对 | Icor/对 | Iacc | |||

| 85 | 1584 | 1251 | 0.78 | 15 | 1506 | 1451 | 0.96 | 80 | 1449 | 1423 | 0.98 |

| 53 | 2569 | 1987 | 0.76 | 20 | 2907 | 2803 | 0.96 | 50 | 2438 | 2366 | 0.97 |

| 20 | 6358 | 4810 | 0.75 | 30 | 6198 | 5984 | 0.96 | 18 | 6409 | 6287 | 0.98 |

| 15 | 8385 | 6478 | 0.77 | 45 | 8194 | 7817 | 0.95 | 14 | 8241 | 8082 | 0.98 |

表6 不同算法实验结果比较Tab. 6 Comparison of experimental results of different algorithms |

| 数据 | 文献[30]算法 | 文献[33]算法 | 本文算法 | |||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Imatch/对 | Icor/对 | Iacc | Times/s | Imatch/对 | Icor/对 | Iacc | Times/s | Imatch/对 | Icor/对 | Iacc | Times/s | |||

| 第1组 | 2577 | 1933 | 0.75 | 25 | 6466 | 5341 | 0.82 | 98 | 2490 | 2283 | 0.91 | 68 | ||

| 第2组 | 2455 | 2055 | 0.83 | 24 | 1479 | 1325 | 0.89 | 77 | 2482 | 2403 | 0.97 | 65 | ||

| 第3组 | 2569 | 1987 | 0.76 | 26 | 2907 | 2803 | 0.96 | 85 | 2438 | 2387 | 0.98 | 65 | ||

| 第4组 | 2218 | 1796 | 0.81 | 21 | 2318 | 2109 | 0.91 | 84 | 2175 | 2068 | 0.95 | 47 | ||

| 均值统计 | 2454 | 1618 | 0.79 | 24 | 3292 | 2894 | 0.90 | 86 | 2396 | 2285 | 0.95 | 61 | ||

| [1] |

|

| [2] |

|

| [3] |

凌霄. 基于多重约束的多源光学卫星影像自动匹配方法研究[D]. 武汉:武汉大学, 2017.

[

|

| [4] |

马方龙. 基于归一化积相关匹配的彩色图像灰度化研究[D]. 兰州:兰州大学, 2018.

[

|

| [5] |

杨佳宾, 姜永涛, 杨幸彬, 等. 基于Dense SIFT特征的无人机影像快速拼接方法[J]. 地球信息科学学报, 2019, 21(4):588-599.

[

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

施颖琦, 顾力栩. 基于互信息多步骤优化的医学图像配准[J]. 计算机工程, 2006, 32(22):187-188.

[

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

姜文聪, 张继贤, 程春泉, 等. SIFT与粗差剔除算法相结合的机载SAR影像匹配研究[J]. 地球信息科学学报, 2013, 15(3):440-445.

[

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

李建晔. 点、线结合下的多源高分辨率遥感影像匹配[D]. 阜新:辽宁工程技术大学, 2012.

[

|

| [22] |

刘肃艳, 王竞雪. 结合同名点及核线约束的近景影像直线匹配[J]. 测绘科学, 2019, 44(10):128-135.

[

|

| [23] |

梁艳, 盛业华, 张卡, 等. 利用局部仿射不变及核线约束的近景影像直线特征匹配[J]. 武汉大学学报·信息科学版, 2014, 39(2):229-233.

[

|

| [24] |

鲜翠琼, 秦学, 朱道恒, 等. 一种图文组合相似度算法的设计与优化[J]. 软件工程, 2020, 23(8):9-12.

[

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

张卡, 盛业华, 叶春. 基于数字视差模型和改进SIFT特征的数字近景立体影像匹配[J]. 测绘学报, 2010, 39(6):624-630.

[

|

| [29] |

吴波. 自适应三角形约束下的立体影像可靠匹配方法[D]. 武汉:武汉大学, 2006.

[

|

| [30] |

王竞雪, 张晶, 张雪. 迭代三角网约束的近景影像密集匹配[J]. 信号处理, 2018, 34(3):347-356.

[

|

| [31] |

自然资源部国土卫星遥感应用中心. 自然资源卫星影像云服务平台[DB/OL]. http://sasclouds.com/chinese/normal/.

[Land Satellite Remote Sensing Application Center, Ministry of Natural Resources. The Cloud Service Platform of Natural Resources Satellite Images[DB/OL]. http://sasclouds.com/chinese/normal/.]

|

| [32] |

欧阳欢, 范大昭, 纪松, 等. 结合离散化描述与同名点约束的线特征匹配[J]. 测绘学报, 2018, 47(10):1363-1371.

[

|

| [33] |

|

/

| 〈 |

|

〉 |