Journal of Geo-information Science >

Multi-scale Cross Dual Attention Network for Building Change Detection in Remote Sensing Images

Received date: 2023-07-28

Revised date: 2023-10-06

Online published: 2023-12-05

Supported by

National Natural Science Foundation of China(61972414)

National Key Research and Development Program of China(2016YFC0303707)

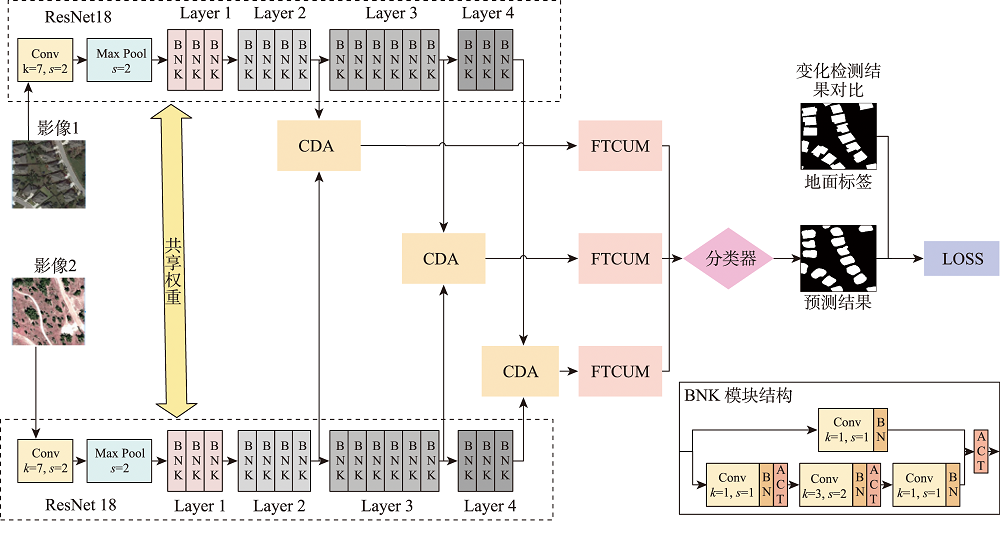

Remote sensing image change detection is a crucial technique that utilizes remote sensing technology to analyze and compare image data captured at different time periods or scenes. In practice, features at varying scales encompass diverse representation ranges, enabling the extraction of more comprehensive and detailed information. This paper proposes a Multi-Scale Cross Dual Attention Network (MSCDAN) method for building change detection in remote sensing images using the multi-scale Cross Dual Attention (CDA) mechanism and residual convolution neural network architecture. The proposed method leverages the characteristics of a residual network to extract change features of different dimensions from remote sensing images. For each feature dimension, a CDA module is created, which utilizes both cross attention and dual attention mechanisms. It combines spatiotemporal information to capture time-series features of surface changes and identifies time-series related change patterns, such as periodic and persistent changes. In this way, the multi-scale CDA module enhances the correlation between different perspectives or feature maps within the input data, which facilitates the exchange and fusion of information in multiple dimensions and enhances the model capability for complex change scenes, leading to improved change detection performance. A Fully Transposed Convolutional Upsampling Module (FTCUM) is introduced to perform local feature fusion for each point in the feature map, and the change boundary is identified by the neural network. This avoids the problems of blurring and jaggedness brought by traditional methods like bilinear interpolation and allows for end-to-end training and optimization, making the method more effective in meeting the requirements of change detection tasks. Extensive experiments are conducted on two benchmark datasets, namely WHU-CD and DSIFN, to evaluate the performance of the proposed method. Compared to the mainstream method, i.e., DTCDSCN (Dual-Task Constrained Deep Siamese Convolutional Network), our proposed method increases the accuracy by 5.13% on the DSIFN dataset and by 1.3% on the WHU-CD dataset. Additionally, for other exiting methods, the proposed method is also better than the ChangeNet and LamboiseNet on the three datasets and outperforms the improved DeepLabv3+ and SRCD-Net on the CDD Dataset. These exceptional findings across various datasets confirm the effectiveness of the proposed method in detecting changes in remote sensing images. Through the application of residual networks and attention mechanisms, our approach achieves superior results in intricate scenarios. This study shows that our proposed method performs remarkably well on various datasets. It serves as a reference for further comprehensive research on remote sensing image change detection using multi-scale cross-pairwise attention networks.

ZHANG Jianbing , YAN Zexiao , MA Shufang . Multi-scale Cross Dual Attention Network for Building Change Detection in Remote Sensing Images[J]. Journal of Geo-information Science, 2023 , 25(12) : 2487 -2500 . DOI: 10.12082/dqxxkx.2023.230432

表1 不同方法在LEVIR-CD、WHU-CD和DSIFN数据集上的精确率(Pre.)、召回率(Rec.)、IoU、 分数与准确率(OA)对比Tab. 1 Comparison of Pre., Rec., IoU, score and OA of different methods on LEVIR-CD, WHU-CD and DSIFN dataset (%) |

| 模型 | LEVIR-CD | WHU-CD | DSIFN | |||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Pre. | Rec. | IoU | F1 | OA | Pre. | Rec. | IoU | F1 | OA | Pre. | Rec. | IoU | F1 | OA | ||||

| ChangeNet | 69.81 | 50.15 | 68.71 | 78.30 | 96.62 | 81.60 | 58.66 | 72.15 | 83.45 | 97.51 | 78.16 | 85.69 | 71.45 | 81.75 | 86.20 | |||

| LamboiseNet | 80.51 | 94.14 | 77.37 | 85.66 | 97.12 | 65.24 | 83.22 | 60.68 | 69.99 | 93.54 | 77.54 | 78.35 | 64.32 | 77.83 | 79.93 | |||

| DTCDSCN | 88.53 | 86.83 | 78.05 | 87.67 | 98.77 | 63.92 | 82.30 | 56.19 | 71.95 | 97.42 | 53.87 | 77.99 | 46.76 | 63.72 | 84.91 | |||

| MSCDAN | 89.68 | 84.49 | 86.17 | 89.30 | 98.81 | 88.82 | 81.41 | 77.52 | 84.95 | 98.69 | 85.61 | 84.37 | 78.66 | 84.99 | 89.27 | |||

表2 不同方法在CDD数据集上的精确率(Pre.)、召回率(Rec.)、IoU、 分数与准确率(OA)对比Tab. 2 Comparison of Pre., Rec., IoU, score and OA of different methods on CDD dataset (%) |

| 模型 | Pre. | Rec. | IoU | F1 | OA |

|---|---|---|---|---|---|

| 改进Deep Labv3+ | 87.30 | 90.20 | — | 88.40 | 96.40 |

| SRCD-Net | 92.55 | 93.34 | 86.81 | 92.94 | — |

| MSCDAN | 93.68 | 92.80 | 88.74 | 93.18 | 97.92 |

| [1] |

张良培, 武辰. 多时相遥感影像变化检测的现状与展望[J]. 测绘学报, 2017, 46(10):1447-1459.

[

|

| [2] |

张钰屏, 刘籽琳, 陈天其. 遥感影像变化检测研究进展[J]. 电脑与信息技术, 2023, 31(2):15-18.

[

|

| [3] |

杨洋, 李轶鲲, 杨树文, 等. 基于空间模糊C均值聚类和贝叶斯网络的高分一号遥感影像变化检测[J]. 测绘与空间地理信息, 2023, 46(4):34-37,42.

[

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

黄维, 黄进良, 王立辉, 等. 基于PCA的变化向量分析法遥感影像变化检测[J]. 国土资源遥感, 2016, 28(1):22-27.

[

|

| [10] |

|

| [11] |

黄晓君, 颉耀文, 卫娇娇, 等. 基于变化检测-CART决策树模式自动识别沙漠化信息[J]. 灾害学, 2017, 32(1):36-42.

[

|

| [12] |

田青林, 秦凯, 陈俊, 等. 基于注意力金字塔网络的航空影像建筑物变化检测[J]. 光学学报, 2020, 40(21):2110002.

[

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

刘英, 何雪, 李单阳, 等. 注意力引导全尺度连接网络的高分辨率影像变化检测[J]. 遥感学报, 2022.

[

|

| [17] |

赵祥, 王涛, 张艳, 等. 基于改进DeepLabv3+孪生网络的遥感影像变化检测方法[J]. 地球信息科学学报, 2022, 24(8):1604-1616.

[

|

| [18] |

陈婕, 刘纪平, 徐胜华. 增强边缘信息的全卷积神经网络遥感影像建筑物变化检测[J]. 测绘通报, 2023(6):61-67.

[

|

| [19] |

高建文, 管海燕, 彭代锋, 等. 基于局部-全局语义特征增强的遥感影像变化检测网络模型[J]. 地球信息科学学报, 2023, 25(3):625-637.

[

|

| [20] |

宋文宣, 彭代锋. 一种改进全卷积网络的遥感影像变化检测[J]. 遥感信息, 2022, 37(6):130-136.

[

|

| [21] |

代云锋, 刘丽娜. 结合改进混合卷积模型的遥感影像变化检测[J]. 遥感信息, 2022, 37(6):53-59.

[

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

边继龙, 王厚博, 李金凤. 基于多尺度注意力网络的立体匹配方法[J]. 北京邮电大学学报, 2021, 44(3):27-34.

[

|

| [27] |

|

| [28] |

|

| [29] |

刘春娟, 乔泽, 闫浩文, 等. 基于多尺度互注意力的遥感图像语义分割网络[J]. 浙江大学学报(工学版), 2023, 57(7):1335-1344.

[

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

/

| 〈 |

|

〉 |