基于YOLOv5算法的飞机类型光学遥感识别

|

龙怡灿(1990—),女,湖南保靖人,硕士生,主要从事数字摄影测量与遥感方向研究。E-mail: long_yican@126.com |

收稿日期: 2021-07-03

要求修回日期: 2021-08-24

网络出版日期: 2022-05-25

基金资助

高分遥感测绘应用示范系统(二期项目)(42-Y30B04-9001-19/21)

国家自然科学基金项目(41401534)

国家自然科学基金项目(41971427)

版权

YOLOv5 based on Aircraft Type Detection from Remotely Sensed Optical Images

Received date: 2021-07-03

Request revised date: 2021-08-24

Online published: 2022-05-25

Supported by

The High Resolution Remote Sensing, Surveying and Mapping Application Demonstration System (Phase Ⅱ)(42-Y30B04-9001-19/21)

National Natural Science Foundation of China(41401534)

National Natural Science Foundation of China(41971427)

Copyright

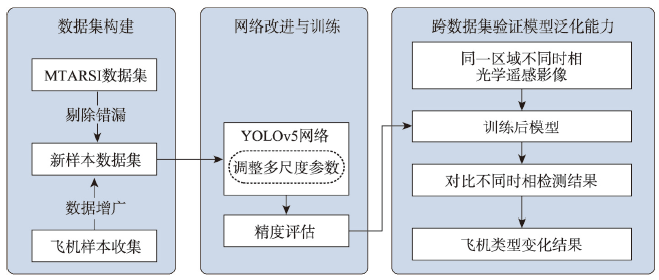

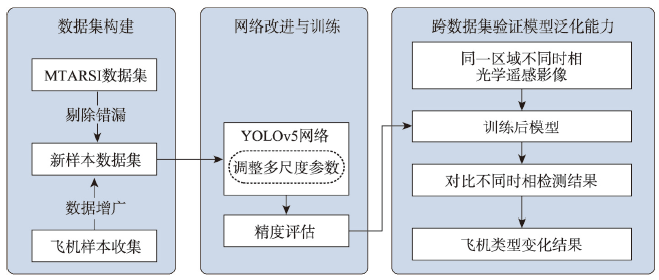

飞机类型检测是遥感影像分析领域的研究热点,在机场监控和情报分析等应用中起着重要的作用。其中,深度学习方法作为遥感影像分析领域广泛应用的手段之一,在飞机类型检测任务中仍面临许多问题,如使用未公开的自制数据集、实验复现困难、无法验证泛化能力等。同时,光学遥感影像易受光照条件、云雨变化等因素影响,使检测任务更加困难。为了解决这些问题,本文首先利用MTARSI数据集对样本进行筛选,再结合Google Earth等开源方法收集飞机影像,采用随机旋转、改变亮度等方法构建新的飞机类型检测数据集。其次,采用YOLOv5作为基础网络框架,针对其多层卷积和池化操作可能会削弱或完全丢失飞机特征的问题,进行多尺度优化训练,有效检测飞机类型特征。最后,利用跨数据集验证模型的泛化能力。实验结果表明,本文方法能准确、有效地检测出光学遥感影像中的飞机的具体类型,具有较强的鲁棒性和泛化能力,跨数据集进行飞机类型检测正确率达到82.12%,可为智能化的飞机目标语义分析、星上应用等研究提供技术支撑。

龙怡灿 , 雷蓉 , 董杨 , 李东子 , 赵琛琛 . 基于YOLOv5算法的飞机类型光学遥感识别[J]. 地球信息科学学报, 2022 , 24(3) : 572 -582 . DOI: 10.12082/dqxxkx.2022.210369

Automatic detection of aircrafts plays an important role in airport monitoring and intelligence analysis. Currently, there are various and mature methods for aircraft detection, but the aircraft type detection is still facing many problems, such as the use of unpublicized self-made datasets, the difficulty to reproduce experiment, and the inability to verify generalization ability. Therefore, detecting aircraft type quickly and accurately is still a hotspot in the field of remote sensing image analysis. The traditional detection methods are complicated in processes, poor in robustness and generalization, and cannot detect the specific type of aircrafts. In recent years, deep learning methods have been widely applied in the field of computer vision. Compared with the two-stage algorithm, YOLO, as a one-stage algorithm, rejects the steps of multiple regression, includes only a convolution network, and regards the detection problem as the regression problem of image classification and candidate box parameters. However, multi-layer convolution and pooling may weaken or completely lose aircraft features, making it challenging to extract practical features. Meanwhile, remote sensing images are susceptible to light conditions, seasonal changes, cloud occlusion, noise, and other factors, which makes the detection task harder. In order to solve these problems, this paper firstly used the MTARSI dataset to screen samples and then collected aircraft images from open-source methods such as Google Earth using random rotation, changed brightness, added noise, and other methods to form a new aircraft type detection dataset. Secondly, multi-scale adjustment and training were carried out based on YOLOv5. Finally, an across-dataset was used to identify the aircraft in the optical remote sensing images, which could verify the model’s generalization ability. The experimental results show that the method can accurately and effectively detect the number, location, and type of aircraft in the optical remote sensing images and has strong robustness and generalization ability. The accuracy of type detection reached 82.12% in the across-dataset, which can provide technical support for intelligent aircraft semantic analysis and on-board application research.

图9 跨数据集检测实验结果二注:绿框为检测正确的飞机;黄框为影像局部放大;红圈为漏检的飞机。 Fig. 9 Across dataset test result 2 |

表2 各场景影像检测语义结果Tab. 2 Each scenario detects semantic results |

| 时相1 | 时相2 | |

|---|---|---|

| 场景1 | 4架C-17 | 5架 C-17 |

| 场景2 | 4架C-135 | 5架C-135 |

| 场景3 | 5架C-135; 1架C-17 | 5架C-135 |

| 场景4 | 21架C-135 | 12架C-135 |

| 模拟场景5 | 21架C-135 | 11架C-135 |

| [1] |

李德仁. 我国测绘遥感技术发展的回顾与展望[J]. 中国测绘, 2019(2):24-27.

[

|

| [2] |

董志鹏, 王密, 李德仁, 等. 遥感影像目标的尺度特征卷积神经网络识别法[J]. 测绘学报, 2019, 48(10):1285-1295.

[

|

| [3] |

项盛文, 文贡坚, 高峰. 知识驱动下的飞机目标变化检测方法[J]. 国土资源遥感, 2016, 28(4):77-82.

[

|

| [4] |

|

| [5] |

|

| [6] |

徐俊峰, 张保明, 余东行, 等. 多特征融合的高分辨率遥感影像飞机目标变化检测[J]. 遥感学报, 2020, 24(1):37-52.

[

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

陆保国, 梁博, 马焕芳. 光学遥感影像飞机目标识别与分类方法[J]. 指挥信息系统与技术, 2020, 11(5):78-82,88.

[

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

史通, 王洁, 罗畅, 等. 用于迁移学习的飞机遥感图像数据集的建立[J]. 火力与指挥控制, 2018, 43(12):78-80,84.

[

|

| [25] |

黄蓉蓉. 深度学习在军用飞机识别与检测中的应用[D]. 兰州:兰州大学, 2020.

[

|

| [26] |

|

| [27] |

Ultralytics. YOLOv5[EB/OL]. 2020:, http://github.com/ultralytics/yolov5

|

| [28] |

江大白 深入浅出Yolo系列之Yolov5核心基础知识完整讲解[EB/OL]. CSDN, 2020, https://blog.csdn.net/nan355655600/article/details/107852353

[

|

| [29] |

周志华. 机器学习[M]. 北京: 清华大学出版社, 2016.

[

|

| [30] |

|

/

| 〈 |

|

〉 |