1 引言

果树树冠信息直接反映了果树生长状况,是评估果树生长活力和表征作物覆盖度的重要指标[1]。因此,准确快速地获取果树树冠信息对于果园精细化管理和产量评估具有重要的实用价值。

当前,遥感已成为果树信息提取的重要技术手段之一。根据特征提取的不同,树冠提取大致可分为两大类:传统分割方法和基于深度学习的分割方法。传统树冠分割方法主要有基于图像强度、树冠形状和树冠纹理等方法[2]。基于图像强度的方法主要利用树冠和背景像素灰度变化(如边缘检测[3]、灰度梯度[4]等)来分割树冠,在树冠与背景存在较大差异的情况下具有一定优势,但难以解决高郁闭度、复杂背景下树冠遮挡与背景干扰问题;基于树冠形状的方法主要利用树冠形态特征来提取影像中树冠信息,应用较为广泛的方法包括分水岭算法[5-6]、模板匹配[7]、谷地跟踪法[8]等,这些方法在树冠形态单一的情况下树冠分割效果较好,但自动化程度较低;基于树冠纹理的方法主要包括超像素分割[9]和区域生长法[10],这些方法在树冠形态与背景简单的情况下分割效果较好,而不适用于复杂树冠分割。

相比传统方法,深度学习在语义分割、目标检测与分类等方面性能提升显著,许多研究人员将深度学习方法引入到遥感地物分类应用中[11⇓-13]。在树冠分割方面,具有代表性的方法包括:Morales等[14]利用DeepLabV3+进行不同场景下树冠分割,Guirado和Braga等[15-16]采用Mask R-CNN模型在高分辨率卫星影像中分割出热带森林和旱地的树冠。除上述基于可见光遥感影像分割树冠的方法外,也包括利用近红外波段等多光谱遥感影像的深度神经网络分割方法,这些方法能获得比仅采用可见光影像更好的分割效果,具有代表性的方法有:Li 等[17]将多波段遥感影像作为SegNet和U-Net的输入,提取大面积向日葵的倒伏信息,获得了88.23%的准确率;Hao等[18]利用6个波段的无人机多光谱影像作为Mask R-CNN网络的输入数据进行树冠分割,结果表明引入多波段遥感影像能显著提升树冠分割性能。此外,一些卷积神经网络(Convolutional Neural Network,CNN)如FCN、U-Net、SegNet和Faster R-CNN也被用于树冠分割[19-20]。尽管上述基于CNN的模型提取到的局部语义信息有助于准确地分割树冠边界,但这些模型受限于感受野大小而难以提取全局上下文语义信息,使得基于CNN的模型对长距离依赖关系较为敏感,导致复杂背景下树冠与背景区分困难。为获取全局上下文语义信息,Dosovitskiy等[21]将Transformer模型引入到图像处理领域,提出了首个用于图像识别的纯自注意力机制网络,该网络能够对长距离依赖关系进行建模,但网络中的图像切分操作会使不同序列像素之间信息流动受限,难以提取到局部语义信息,从而导致感兴趣目标边界识别不准确。针对CNN和Transformer存在全局和局部语义信息不足问题,Chen等[22]提出一种结合CNN与Transformer的融合神经网络来同时提取目标对象的局部和全局语义信息,该网络在医学影像分割任务中效果较好,但网络串行结构破坏了CNN和Transformer各自的特性,无法有效保留提取到的局部和全局语义信息,也未考虑与目标对象边缘至关重要的位置信息,导致复杂场景下目标分割存在较多错分和漏分现象。除分割方法方面存在不足之外,单一数据源也是制约树冠分割精度提高的重要原因之一,基于可见光遥感影像的分割方法难以剔除与树冠光谱相似的植被干扰,而且目前大多数基于二维影像的深度学习树冠分割方法因未顾及树冠表面三维几何结构形态而难以消除地形起伏的影响。

为解决上述问题,本文借鉴CNN和Transformer的优点,提出一种耦合卷积神经网络与注意力机制的复合型神经网络(Convolutional Neural Network and Attention Mechanism Coupled Neural Network,CNNAMNet)来提取与果树树冠关联的局部与全局语义信息,并设计一种局部与全局特征融合模块(Local and Global Feature Fusion Module,LGFFM)来实现属性与空间位置协同树冠分割。同时,通过引入树冠高度模型(Canopy Height Model,CHM)以消除地形起伏和低矮植被的影响,实现复杂地形下杂草或灌木茂密区域果树树冠分割。

2 研究方案

2.1 技术路线

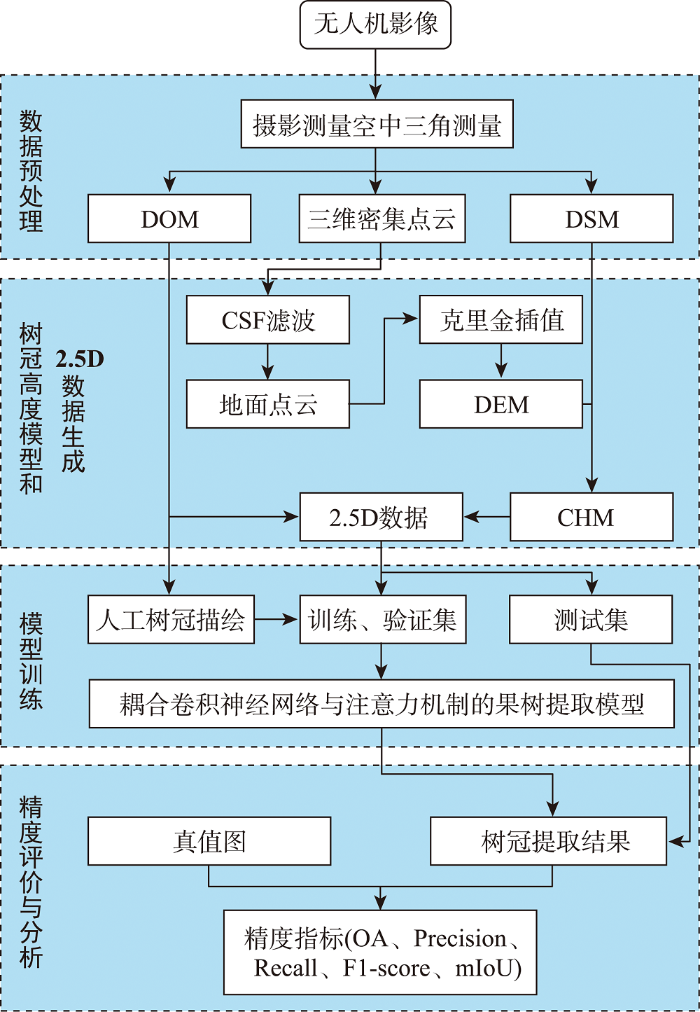

本文提出了一种耦合卷积神经网络与注意力机制的复合型神经网络(CNNAMNet),以解决复杂背景下(地形起伏、杂草灌木茂密)果树树冠分割的问题,技术路线见图1,主要包括摄影测量空中三角测量、树冠高度模型和2.5D数据生成、模型训练及精度评价与分析4个部分。

图1

2.2 树冠高度模型和2.5D数据生成

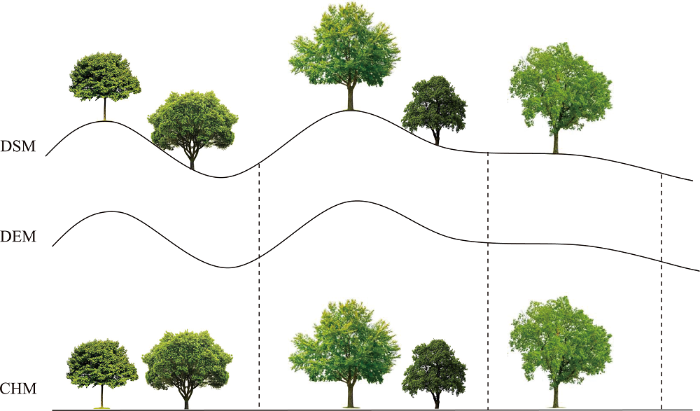

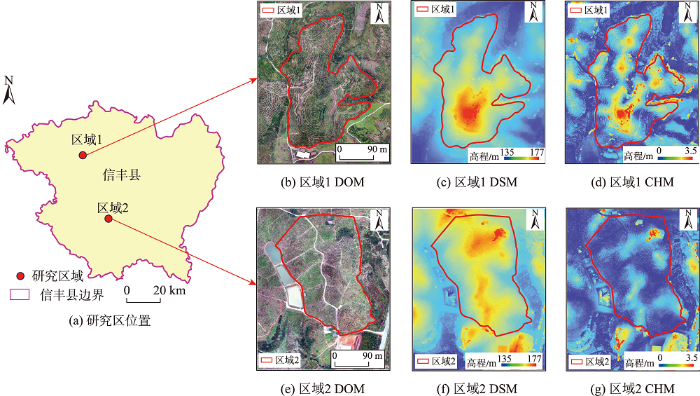

本研究中,通过无人机摄影测量得到的数字正射影像(Digital Orthophoto Map, DOM)、数字表面模型(Digital Surface Model, DSM)和三维密集点云是果树参数提取和分析重要的数据源。① 利用布料模拟滤波(Cloth Simulation Filter,CSF)方法从三维密集点云中分离出地面点云,并通过克里金插值运算得到表征地形起伏的数字高程模型(Digital Elevation Model, DEM);② 基于DSM与DEM之间的差分运算,见式(1),得到表征树冠几何结构形态的树冠高度模型[23](Canopy Height Model,CHM),见 图2; ③ 将CHM与DOM进行通道组合,生成具有树冠高度信息的数据,并定义为2.5D数据。

图2

2.3 耦合卷积神经网络与注意力机制的复合型神经网络模型

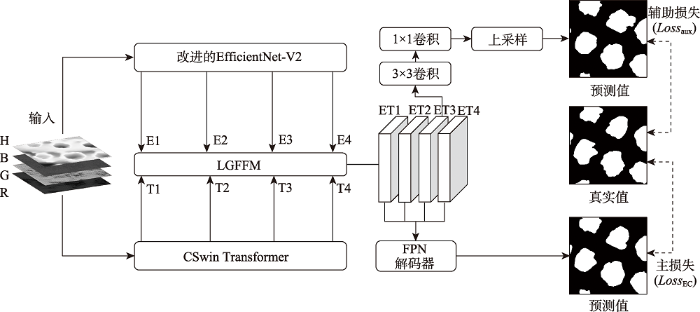

顾及局部和全局上下文信息在果树树冠特征表达与提取方面的优势,本文提出一种耦合卷积神经网络与注意力机制的复合型神经网络模型来分割果树树冠。CNNAMNet网络模型核心部分包括局部与全局语义信息提取、坐标注意力模块和全局与局部特征融合模块等。

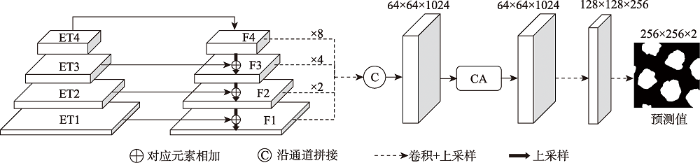

相比其它网络,卷积神经网络EfficientNet-V2和注意力机制网络CSwin Transformer由于模型参数量少和计算复杂度低,分别在局部和全局信息提取方面具有显著优势[24⇓-26]。然而,由于EfficientNet-V2中的卷积核感受野有限,以及CSwin Transformer中的图像切分操作会使不同序列像素之间的信息流动受限,导致EfficientNet-V2和CSwin Transformer在全局和局部信息提取方面仍存在不足。为解决这些问题,本文提出CNNAMNet模型,用于果树树冠分割,网络架构见图3。① 该网络通过EfficientNet-V2和CSwin Transformer提取局部和全局语义特征,并基于坐标注意力[27](Coordinate Attention,CA)机制的特征重构模块融合局部与全局信息,以及通过CA机制保留目标对象的空间位置信息以达到精确识别树冠边界的目的;② 将融合后的特征输入到特征金字塔网络[28](Feature Pyramid Networks,FPN)解码器(图4)中,以消除尺度变化对树冠识别效果的影响;③ 本文还引入了一个辅助损失计算解码器[29],以增强融合特征的特性;最后,基于损失函数反向传播优化整个网络模型。

图3

图4

2.3.1 局部与全局语义信息提取

尽管EfficientNet-V2具有优异的局部边缘识别能力,但缺乏全局上下文信息提取能力。而Transformer网络可通过全局自我注意力机制提取影像全局上下文信息,有利于增强果树与非果树(如杂草、灌木等)之间的差异,但全局自注意力计算成本高。针对这一问题,Dong等[26]提出了一种十字形窗口的自注意力机制和CSwin Transformer网络,在水平和垂直条纹内并行计算自注意,并改变Transformer网络不同层条纹宽度,降低计算成本和保持较强的长距离信息建模能力。因此,鉴于CSwin Transformer强大的全局上下文信息提取能力[26],本文通过迁移学习引入该模型提取果树树冠的全局语义信息,且该模型也包含局部增强位置编码(Local enhanced Positional Encoding,LePE),能使CSwin Transformer模型同时具备全局和一定的局部信息提取能力,可增强果树和非果树树冠区分能力。

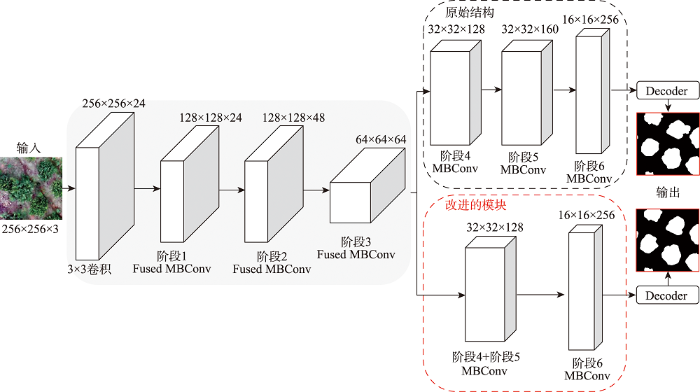

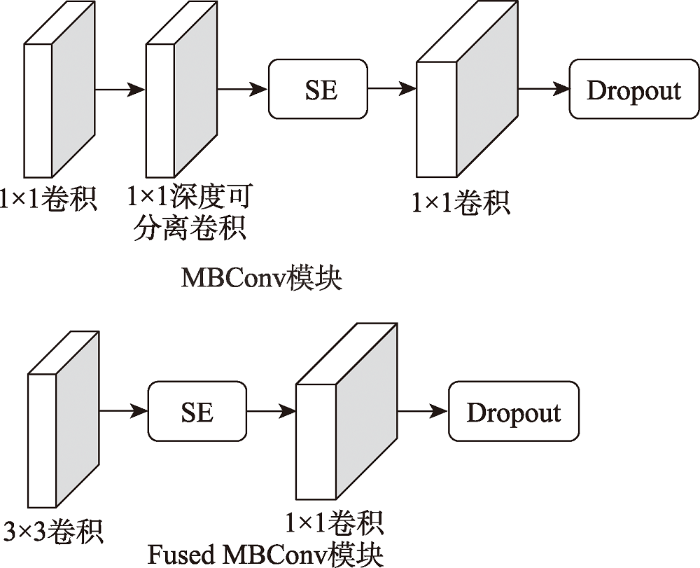

本文研究结合EfficientNet-V2和CSwin Transformer网络模型,实现果树树冠局部与全局深层次高级语义特征提取。此外,为与CSwin Transformer网络提取的全局信息融合,本文对EfficientNet-V2网络结构进行了改进,见图5,将网络结构前2个MBConv阶段合并为一个阶段,使局部与全局信息提取网络接口一致。EfficientNet-V2主要由特征提取层和解码模块(Decoder) 2部分组成,特征提取层包括MBConv模块和Fused MBConv模块,解码模块主要由不同组合方式的卷积层和上采样层组成。其中,MBConv模块由卷积层、深度可分离卷积(Depthwise Conv)、特征压缩激活模块(Squeeze-and-Exciatation,SE)和Dropout正则化函数组成,Fused MBConv模块由卷积层、特征压缩激活模块和Dropout正则化函数组成,两个模块的网络结构见图6。

图5

图6

图6

MBConv模块和Fused MBConv模块结构

Fig. 6

Structure of MBConv module and Fused MBConv module

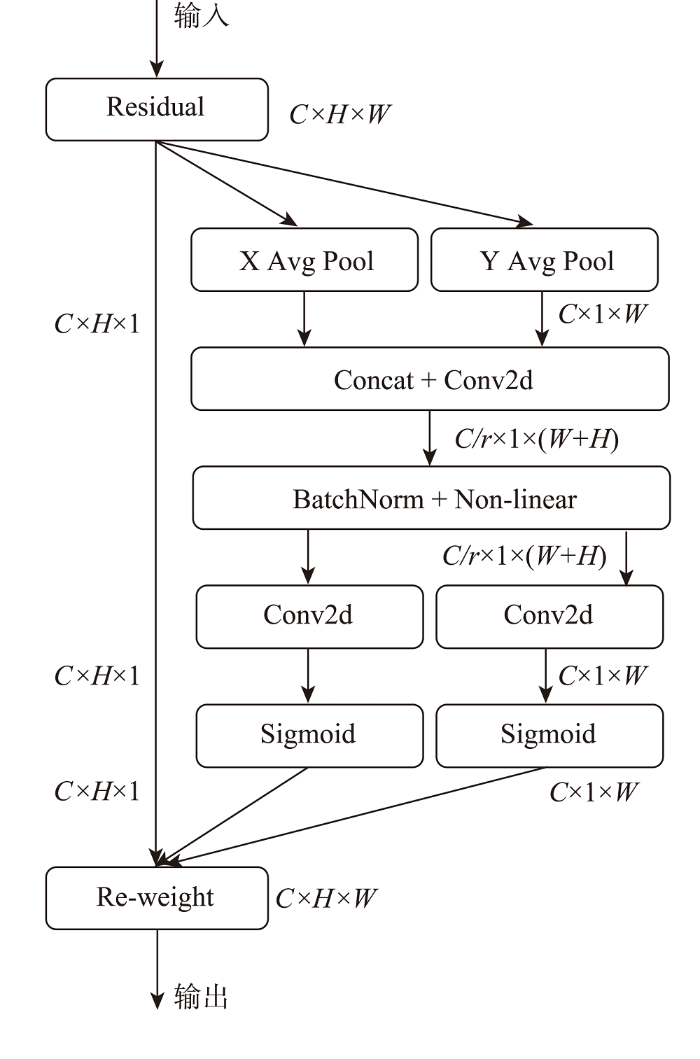

2.3.2 坐标注意力模块

图7

图7

坐标注意机制

注:C、H、W分别表示输入特征图的高、宽和通道数,r表示通道下采样率。

Fig. 7

Coordinate attention mechanism

首先,给定输入层x(大小为H×W×C),每个通道分别采用大小为(H, 1)或(1, W)的池化内核沿水平和垂直坐标进行编码,高为h宽为w处的第c通道的输出为

式中:

其次,在通道维度上执行级联操作和1×1卷积运算,以压缩通道数量和捕获通道间的特征,得到

式中:F为在水平方向和垂直方向上对空间信息进行编码后的中间特征图;

然后,对编码的特征图在通道维度进行等分,采用1×1卷积运算将特征图的通道数量恢复到输入时的通道数量,并利用Sigmoid函数计算特征图中每个像素的权重,得到

式中:g表示对F等分后卷积和激活的权重特征图;

最后,将输出

因此,CA既能捕获通道之间的关联,也可对位置信息和长程关联进行建模,使得模型能够准确定位和识别目标[27]。

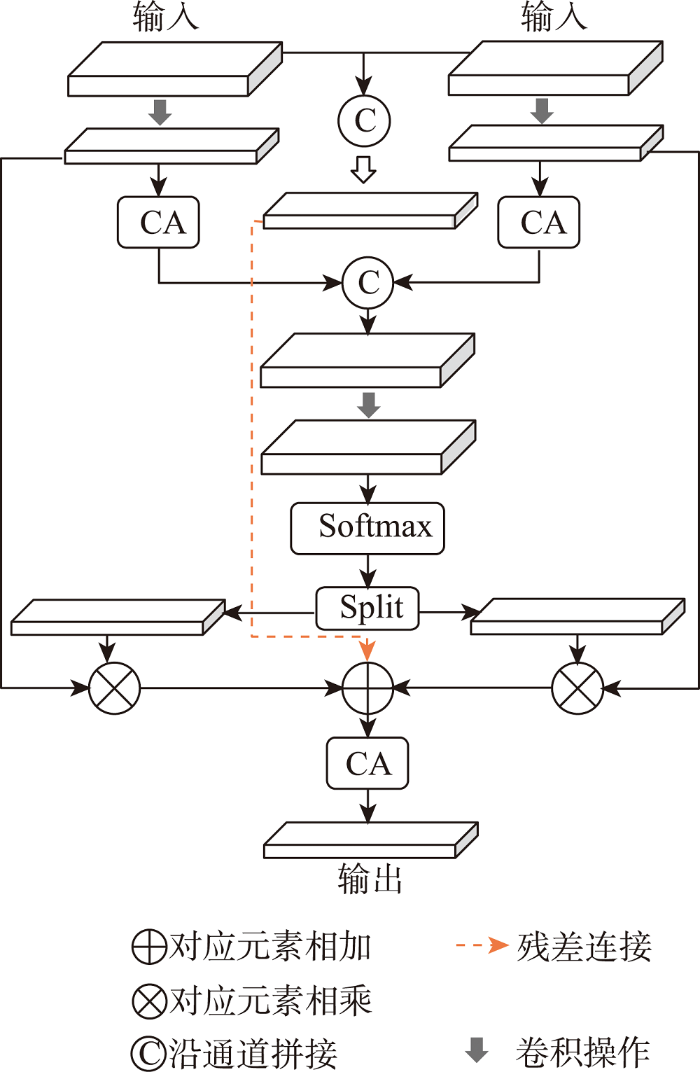

2.3.3 局部与全局特征融合模块

为有效地融合EfficientNet-V2和CSwin Transformer提取的局部和全局特征,本文设计了一种局部与全局特征融合模块(LGFFM),见图8,该模块采用CA机制以自适应地融合不同尺度的高级语义特征,其原理为:

图8

(1)将EfficientNet-V2和CSwin Transformer输出的特征

式中:

(2)在通道维度上将

式中:

(3)分别对EfficientNet-V2和CSwin Transformer分支的特征图进行加权操作,并与残差连接中的特征进行逐元素相加,再输入到CA机制中,以提取加权特征图中目标对象的空间位置信息,其输出的特征为:

式中:e、

3 实验与分析

3.1 实验设计

图9

图9(c)中,区域1地形起伏较大(海拔高度范围135~177 m),存在与树冠可见光谱相似的密集杂草或灌木,部分树冠存在黏连现象,树冠密集程度分布不均匀。图9(f)区域2地形相对平坦,树冠间隔相对较大,由于果树种植周期不同,区域内存在较多长势不一的果树。区域1和区域2的面积分别约为3 869 m2和4 052 m2,平均树冠直径分别为3.3 m和3.1 m。研究区中树冠黏连问题使得利用缺乏局部语义信息的纯自注意力机制模型难以准确地识别出树冠边界;而树冠较小的果树与杂草灌木大小形状相似,导致缺乏全局语义信息的经典CNN模型不易区分果树树冠与背景。因此,利用存在树冠黏连和树木长势不一现象的本文区域能够较好地对比验证本文CNNAMNet模型在复杂背景下果树树冠分割效果。

本文研究采用大疆Phantom 4 RTK无人机采集数据(时间:2020年10月9—12日上午),影像采集时天气晴朗、少云无风,无人机飞行高度约为80 m,航向重叠度和旁向重叠度为80%,飞行速度为5 m/s,地面分辨率为0.03 m,图像分辨率为5 472像素× 3 648像素。

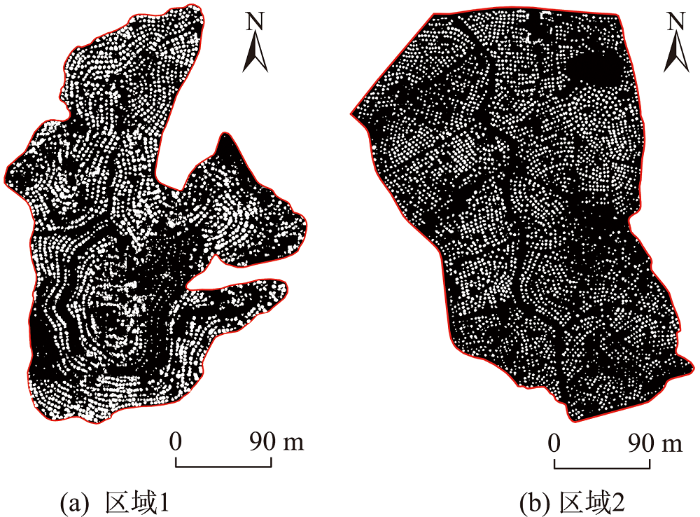

本文采用Agisoft Photoscan 1.4软件进行无人机摄影测量数据预处理,生成研究区DOM、DSM和三维密集点云。为获得网络模型训练与测试样本,本文采用ArcGIS 10.8软件从研究区正射影像中人为边缘标注树冠作为真实样本,共标注出3 559个树冠样本。为获得研究区CHM,采用CSF滤波方法从密集点云中分离出地面点云以消除地表地物等非地形信息影响,利用克里金插值生成DEM,并根据公式(1)计算得到研究区CHM。为突出树冠和复杂背景之间的差异,本文将DOM与CHM进行通道组合,得到具有树冠高度信息的数据,即2.5D数据。

通过迁移学习共享预训练模型EfficientNet-V2和CSwin Transformer的参数,在果树树冠提取精化训练中采用不同地形复杂背景下以256像素×256像素大小的图像块作为训练和测试样本,共获得5 518张影像,将所有样本按4:1的比例划分为训练集和测试集。同时,采用水平与垂直翻转、旋转90°、180°和270°、仿射变换等方式进行数据扩充,共获得26 484张训练样本和6 624张测试样本。

在大多数分割效果定量评价中,总体精度(Overall Accuracy, OA)、精确度(Precision)、召回率(Recall)、F1评分和均交并比(Mean Intersection over Union,mIoU) 5个评价指标是评价分割精度的常用指标[12]。在本文中,OA用来表示正确预测的像素点占总像素点的比例,反映了模型的总体预测精度;Precision用来表示冠层像素点中正确预测的冠层像素点占总冠层像素点的比例,反映了模型识别树冠的能力;Recall用来表示冠层像素点中正确预测的冠层像素点占人工标记的冠层像素点数量的比例,反映了模型识别树冠轮廓是否完整;F1评分用来表示精确度与召回率的调和平均值,以更全面地反映模型识别冠层的效果;mIoU用来表示冠层像素点中预测像素点和人工标记的像素点的交集与并集比例的平均值,反映了模型所检测的冠层区域的准确性。这5个评价指标计算公式为:

式中:k表示第k个类别;K表示总类别数量;P表示正确预测的像素点;N表示错误预测的像素点;TP表示正确预测的果树树冠像素点;FP表示将背景预测为果树树冠的错误像素点;TN表示正确预测的背景像素点;FN表示将果树树冠预测为背景的 错误像素点。

3.2 实验结果与分析

3.2.1 消融实验

为验证局部与全局特征融合模块(LGFFM)、坐标注意力机制(CA)和辅助损失函数(Lossaux)的有效性和适用性,本文采用2.5D实验数据,对LGFFM、CA和Lossaux进行了消融实验,实验结果见表1。由表1可知,同时引入3个模块的CNNAMNet模型获得了最高评价指标数值,OA、F1评分和mIoU分别为97.57%、95.49%和94.05%。其中,相比于Baseline (3个模块均未引入),引入LGFFM模块融合了局部和全局信息,对分割性能提升最大,mIoU指标提高了1.72%;而引入CA增强了感兴趣对象的位置信息,Lossaux增强了网络的学习特性,mIoU分别提高了1.09%和0.51%,可见引入LGFFM、CA和Lossaux均能有效地提高果树树冠分割性能。此外,LGFFM模块一方面能有效地减少CNN与Transformer特征融合过程中信息的丢失,也兼顾了树冠局部语义信息和全局上下信息;另一方面引入坐标注意力机制提取树冠的空间位置信息,能增强对树冠边界的感知,整体上提高了树冠提取精度。在模型解码阶段,CA模块能在恢复图像分辨率过程中提取树冠的空间位置信息,减少了空间信息的丢失。而辅助损失函数有助于果树树冠语义信息提取和优化网络训练。

表1 LGFFM、CA和Lossaux的消融实验结果

Tab. 1

| 方法 | OA | F1 | mIoU |

|---|---|---|---|

| Baseline | 96.33 | 93.02 | 91.05 |

| Net + LGFFM | 97.19 | 93.89 | 92.77 |

| Net + CA | 96.97 | 93.44 | 92.14 |

| Net + Lossaux | 97.04 | 92.93 | 91.56 |

| Net + LGFFM + CA | 97.42 | 94.94 | 93.61 |

| Net + CA + Lossaux | 97.07 | 93.74 | 92.69 |

| Net + LGFFM + Lossaux | 97.21 | 94.52 | 93.31 |

| Net + LGFFM + CA + Lossaux (CNNAMNet) | 97.57 | 95.49 | 94.05 |

3.2.2 2.5D数据的树冠分割性能分析

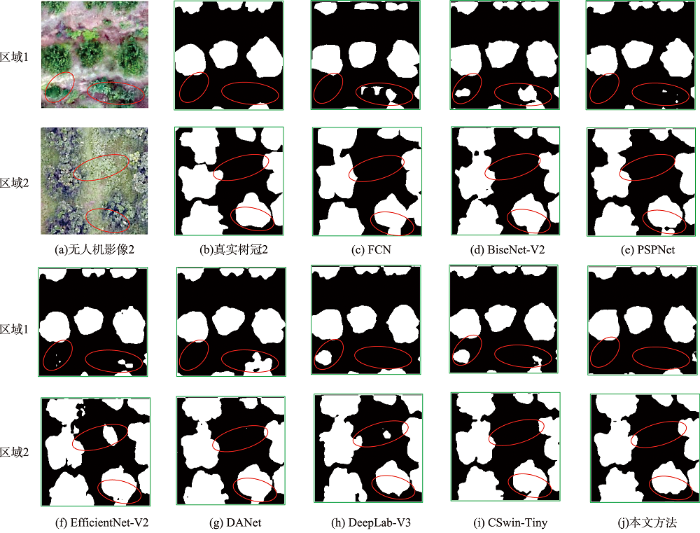

为验证2.5D数据对柑橘果树树冠分割的有效性,本文选用2种分割效果较好的传统方法(即区域生长和分水岭算法)和7种具有代表性的深度学习语义分割模型(即FCN、BiseNet-V2、PSPNet、EfficientNet-V2、DANet、DeepLab-V3、CSwin-Tiny)与CNNAMNet模型进行对比实验,评价指标定量分析结果见表2。由表2可知,CNNAMNet模型的分割精度最高,而区域生长和分水岭算法的树冠分割精度最低,传统方法因不具有高维非线性特征提取能力而难以剔除复杂背景干扰。DANet模型的精度提升最大,F1评分和mIoU分别提高了2.16%和1.91%,这主要是由于模型中的注意力机制能从CHM中提取到全局上下文信息,增强了树冠识别能力。可知,引入2.5D数据能有效地过滤掉低矮杂草和灌木,提高树冠分割精度。此外,本研究提出的CNNAMNet模型在各个评价指标上均比另外7种经典语义分割模型更高。

表2 不同网络模型的2D和2.5D数据树冠分割定量评价结果

Tab. 2

| 方法 | 数据集 | OA | F1 | mIoU |

|---|---|---|---|---|

| 区域生长 | 2D | 80.11 | 77.12 | 74.94 |

| 分水岭算法 | 2D | 87.38 | 82.60 | 80.45 |

| FCN | 2D | 95.29 | 88.71 | 86.97 |

| 2.5D | 95.19 | 90.75 | 88.39 | |

| BiseNet-V2 | 2D | 95.45 | 89.13 | 87.40 |

| 2.5D | 95.64 | 91.23 | 89.21 | |

| PSPNet | 2D | 96.85 | 92.47 | 91.05 |

| 2.5D | 97.09 | 94.41 | 92.94 | |

| EfficientNet-V2 | 2D | 96.89 | 92.80 | 91.47 |

| 2.5D | 96.75 | 93.99 | 92.16 | |

| DANet | 2D | 96.90 | 92.57 | 91.17 |

| 2.5D | 97.15 | 94.73 | 93.08 | |

| DeepLab-V3 | 2D | 97.15 | 93.26 | 91.85 |

| 2.5D | 97.06 | 94.56 | 92.88 | |

| CSwin-Tiny | 2D | 97.08 | 93.29 | 91.96 |

| 2.5D | 97.26 | 94.35 | 92.95 | |

| CNNAMNet | 2D | 97.20 | 94.62 | 93.03 |

| 2.5D | 97.57 | 95.49 | 94.05 |

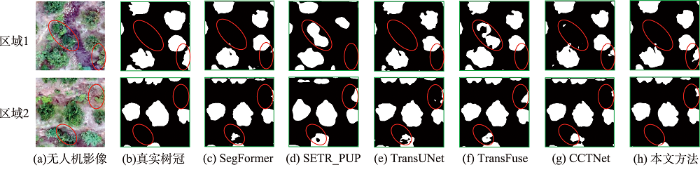

采用本文CNNAMNet模型的2个区域树冠分割结果见图10, 2个具有代表性的子块见图11,可知,CNNAMNet具有更强的树冠和背景区分能力,较少出现错分和漏分现象,主要原因是引入了LGFFM和CA模块,不仅能够较好地保留局部细节和全局上下信息,也可通过提取树冠空间位置信息来确保树冠边界分割的准确性。而其他网络如FCN由于结构中的池化操作破坏了空间信息,造成模型缺乏树冠的局部细节信息,弱化了树冠边界的识别能力;BiseNet-V2和EfficientNet-V2由于卷积操作感受野有限,无法提取到丰富的全局上下文信息,且网络太深难以保留局部细节信息,造成树冠较多的错分和漏分现象。相比之下,PSPNet、DANet和DeepLab-V3采用了金字塔池化模块、注意力机制和空洞空间金字塔池化模块,在一定程度上缓解了卷积神经网络中全局上下文信息不足问题,能提取出相对完整的树冠轮廓,但仍然无法提取到丰富的全局上下文信息,分割后的树冠存在较多错分现象;而CSwin-Tiny能较好地提取到全局上下文信息,但由于局部信息提取能力有限,分割结果存在许多黏连和错分现象。

图10

图10

CNNAMNet柑橘果树树冠分割结果

Fig. 10

Segmentation results of citrus tree canopy using CNNAMNet

图11

图11

CNNAMNet模型部分柑橘果树树冠分割子块对比

注:红色椭圆表示着重分析的区域。

Fig. 11

Comparison of several patches of citrus tree canopy segmentation in CNNAMNet model

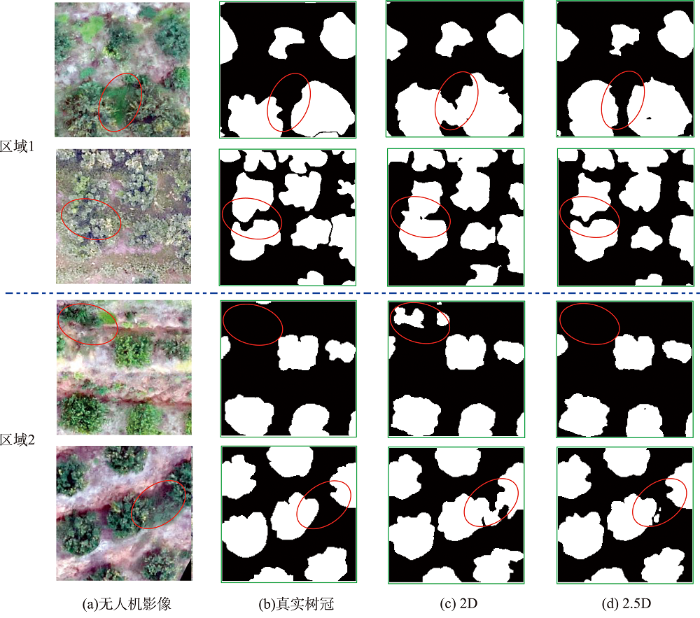

3.2.3 不同背景下树冠分割性能分析

图12

图12

CNNAMNet在不同背景下柑橘果树树冠分割结果对比

注:红色椭圆表示着重分析的区域。

Fig. 12

Comparison of citrus tree canopy segmentation result under different backgrounds using CNNAMNet

表3 CNNAMNet在不同区域和数据的树冠分割定量评价对比

Tab. 3

| 研究区域 | 数据集 | OA | Precision | Recall | F1 | mIoU |

|---|---|---|---|---|---|---|

| 区域1 | 2D | 96.39 | 92.17 | 93.94 | 93.05 | 91.12 |

| 2.5D | 96.94 | 93.61 | 94.56 | 94.08 | 92.39 | |

| 区域2 | 2D | 97.92 | 91.01 | 91.42 | 91.22 | 90.88 |

| 2.5D | 98.27 | 90.95 | 93.05 | 91.99 | 91.62 |

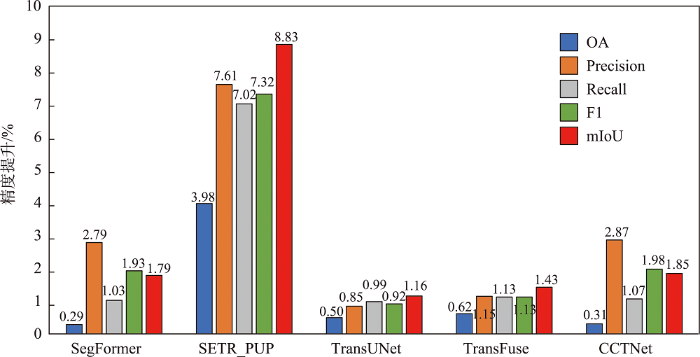

3.2.4 与先进网络的对比分析

表4 CNNAMNet与其他先进网络模型对比结果

Tab. 4

| 方法 | OA | Precision | Recall | F1 | mIoU |

|---|---|---|---|---|---|

| SegFormer | 97.28 | 92.18 | 94.99 | 93.56 | 92.26 |

| SETR_PUP | 93.59 | 87.36 | 89.00 | 88.17 | 85.22 |

| TransUNet | 97.07 | 94.12 | 95.03 | 94.57 | 92.89 |

| TransFuse | 96.95 | 93.82 | 94.89 | 94.36 | 92.62 |

| CCTNet | 97.26 | 92.10 | 94.95 | 93.51 | 92.20 |

| CNNAMNet | 97.57 | 94.97 | 96.02 | 95.49 | 94.05 |

图13

图13

CNNAMNet较已有CNN与Transformer融合方法的精度提升

Fig. 13

Improved accuracy of CNNAMNet compared to the fusion method of CNN and Transformer

此外,柑橘果树树冠分割结果部分子块可视化对比见图14,相比于其他5种模型,CNNAMNet模型误分类像素最少,树冠边界检测效果最好,这是由于CNNAMNet不仅能较好地保留CNN和Transformer各自的优点,也可提取到果树树冠的空间位置信息,有利于精确分割果树树冠。比较而言,其他5种网络模型存在以下问题:① SegFormer和SETR_PUP通过注意力机制编码器来提取图像特征,相比卷积神经网络,局部特征提取能力更弱;② TransUNet由于采用串行结构来融合CNN与Transformer,不能有效地保留CNN和Transformer网络中的局部和全局上下文信息,从而难以精确地检测出果树树冠边界;③ 尽管TransUNet利用跳跃连接能一定程度改善网络模型在解码阶段中空间信息不足问题,但仍未解决特征提取阶段中局部信息丢失的问题;④ TransFuse和CCTNet采用并行结构来融合CNN和Transformer,虽能保留了CNN和Transformer各自的优势,但结构中的采样操作易丢失树冠像素的空间位置信息,导致树冠边界分割不准确。

图14

图14

CNNAMNet与先进网络柑橘果树树冠分割的可视化对比

注:红色椭圆表示着重分析的区域。

Fig. 14

Visualization comparison between the CNNAMNet and state-of-the-art networks for citrus tree canopy segmentation

4 结语

本文针对现有深度神经网络难以同时兼顾局部和全局语义信息而无法满足复杂背景下果树树冠分割的问题,提出一种基于2.5D数据的耦合卷积神经网络与注意力机制的复合型神经网络CNNAMNet,以达到复杂背景下果树树冠精准分割的目的。与其他深度网络模型不同,CNNAMNet模型通过引入CHM来增强树冠和复杂背景之间的差异,以消除地形起伏和低矮杂草灌木对果树树冠分割的影响。实验结果表明,本文提出的CNNAMNet模型在OA、Precision、Recall、F1评分和mIoU评价指标上明显优于其它深度网络模型,果树树冠分割较少错分和漏分现象,OA、F1评分和mIoU最高分别达到97.57%、95.49%和94.05%,与SegFormer、SETR_PUP、TransUNet、TransFuse和CCTNet等先进网络模型相比,mIoU指标分别提升了1.79%、8.83%、1.16%、1.43%和1.85%。因此,本文提出的CNNAMNet模型能实现复杂背景下果树树冠准确分割,对于掌握果树生长状况和果园精细化管理具有重要的实用价值,在果树生长监测方面具有广泛的应用前景。

参考文献

A sudy of the characteristic of the observation angle on the terrestrial image measurement of paddy vegetation cover

[J].

基于标记控制分水岭分割方法的高分辨率遥感影像单木树冠提取

[J].

DOI:10.3724/SP.J.1047.2016.01259

[本文引用: 1]

树冠是树木的重要组成,可以直接反映树木健康状况。高空间分辨率遥感影像和遥感技术为快速获取详细的树冠信息和实时监测林冠变化提供了有效的途径。因此,基于高空间分辨率遥感影像的单木树冠提取方法研究对现代森林管理具有重要意义。本文以黄河三角洲地区孤岛林场人工刺槐林和旱柳为研究对象,以QuickBird影像为数据源,首先利用面向对象方法实现研究区林地和非林地分类;然后以林地为掩膜,提取出树冠分布范围;在此基础上,分别选取疏林区和密林区为试验区域,通过形态学开闭重建滤波,平滑图像,去除噪声;最后,利用标记控制分水岭分割方法分别对疏林区和密林区进行树冠提取。本文以人工勾绘结果为参考进行精度验证,结果显示疏林区F测度达到87.8%,密林区F测度达到65.5%,表明该提取方法简单易行,精度可靠。

Individual tree crown extraction of high resolution image based on marker-controlled watershed segmentation method

[J].

Individual tree crown delineation in a highly diverse tropical forest using very high resolution satellite images

[J].

基于灰度梯度图像分割的单木树冠提取研究

[J].

Single tree crown extraction based on gray gradient image segmentation

[J].

Individual tree crown detection and delineation from very-high-resolution UAV images based on bias field and marker-controlled watershed segmentation algorithms

[J].

利用无人机数码影像进行密植型果园单木分割

[J].

Single tree segmentation in close-planting orchard using UAV digital image

[J].

Comparison of six individual tree crown detection algorithms evaluated under varying forest conditions

[J].

Application of high-resolution airborne data using individual tree crowns in Japanese conifer plantations

[J].DOI:10.1007/s10310-008-0102-8 URL [本文引用: 1]

基于超像素特征向量的果树冠层分割方法

[J].

Segmentation method of fruit tree canopy based on super pixel feature vector

[J].

基于标记控制区域生长法的单木树冠提取

[J].

Individual tree crown delineation using maker-controlled region growing method

[J].

CCTNet: Coupled CNN and transformer network for crop segmentation of remote sensing images

[J].

一种基于深度传递迁移学习的遥感影像分类方法

[J].

DOI:10.12082/dqxxkx.2022.210428

[本文引用: 2]

面对实际的遥感影像分类任务,采用深度神经网络的方法存在的最大问题是缺乏充足的标注样本,如何使用较少的标注样本实现较高精度的遥感影像分类,是目前需要解决的问题。ImageNet作为世界上最大的图像识别数据集,在其上训练出的模型有着丰富的底层特征。对ImageNet预训练模型进行微调是最常见的迁移学习方法,能够一定程度利用其丰富的底层特征,提高分类精度。但ImageNet影像特征与遥感影像差距较大,对分类效果提升有限。为了解决上述问题,本文基于传递迁移学习思想,结合深度神经网络,提出一种基于深度传递迁移学习的遥感影像分类方法。该方法通过构建以开源遥感场景识别数据集为源域的中间域,并以ImageNet预训练权重为源域、待分类遥感影像为目标域进行迁移学习,提高遥感影像分类精度。首先,以ImageNet预训练VGG16网络为基础,为加速卷积层权重更新而将全连接层替换为全局平均池化层,构建GAP-VGG16,使用中间域数据集训练ImageNet预训练GAP-VGG16以获取权重;然后,以SegNet网络为基础,在SegNet中加入卷积层设计了T-SegNet,以对获取的权重进一步地提取。最后,将获取的权重迁移到T-SegNet中,使用目标域数据集训练,实现遥感影像分类。本文选取Aerial Image Dataset和UC Merced Land-Use DataSet作为中间域数据集的数据源,资源三号盘锦地区影像为目标域影像,并分别选取了50%和25%数量的训练样本进行实验。实验结果表明,在50%和25%数量的训练样本下,本文方法分类结果相比SegNet的Kappa系数分别提高了0.0459和0.0545,相比ImageNet预训练SegNet的Kappa系数分别提高了0.0377和0.0346,且在样本数较少的类别上,本文方法分类精度提升更明显。

A remote sensing image classification method based on deep transitive transfer learning

[J].

基于改进全卷积神经网络模型的土地覆盖分类方法研究

[J].

DOI:10.12082/dqxxkx.2023.220435

[本文引用: 1]

遥感卫星数据是地球表面信息的重要来源,但利用传统的遥感分类方法进行土地覆盖分类局限性大、过程繁琐、解译精度依赖专家经验,而深度学习方法可以自适应地提取地物更多深层次的特征信息,适用于高分辨率遥感影像的土地覆盖分类。文中对高分辨率影像中水体、交通运输、建筑、耕地、草地、林地、裸土等进行高精度分类,结合遥感多地物分类的特点,以DeepLabV3+模型为基础,作出了以下改进:① 骨干网络的改进,使用ResNeSt代替ResNet作为骨干网络;② 空洞空间金字塔池化模块的改进,首先在并联的每个分支的前一层增加一个空洞率相对较小的空洞卷积,其次在分支后层加入串联的空洞率逐渐减小的空洞卷积层。使用土地覆盖样本库和自制样本库进行模型训练、测试。结果表明,改进模型在2个数据集的精度和时间效率均明显优于原始DeepLabV3+模型:土地覆盖样本库总体精度达到88.08%,自制样本库总体精度达到85.22%,较原始DeepLabV3+模型分别提升了1.35%和3.4%,时间效率每epoch减少0.39 h。改进模型能够为数据量以每日TB级增加的高分影像提供更加快速精确的土地覆盖分类结果。

Research on land cover classification method based on improved fully convolutional neural network model

[J].

Automatic segmentation of mauritia flexuosa in unmanned aerial vehicle (UAV) imagery using deep learning

[J].One of the most important ecosystems in the Amazon rainforest is the Mauritia flexuosa swamp or “aguajal”. However, deforestation of its dominant species, the Mauritia flexuosa palm, also known as “aguaje”, is a common issue, and conservation is poorly monitored because of the difficult access to these swamps. The contribution of this paper is twofold: the presentation of a dataset called MauFlex, and the proposal of a segmentation and measurement method for areas covered in Mauritia flexuosa palms using high-resolution aerial images acquired by UAVs. The method performs a semantic segmentation of Mauritia flexuosa using an end-to-end trainable Convolutional Neural Network (CNN) based on the Deeplab v3+ architecture. Images were acquired under different environment and light conditions using three different RGB cameras. The MauFlex dataset was created from these images and it consists of 25,248 image patches of 512 × 512 pixels and their respective ground truth masks. The results over the test set achieved an accuracy of 98.143%, specificity of 96.599%, and sensitivity of 95.556%. It is shown that our method is able not only to detect full-grown isolated Mauritia flexuosa palms, but also young palms or palms partially covered by other types of vegetation.

Mask R-CNN and OBIA fusion improves the segmentation of scattered vegetation in very high-resolution optical sensors

[J].

Tree crown delineation algorithm based on a convolutional neural network

[J].Tropical forests concentrate the largest diversity of species on the planet and play a key role in maintaining environmental processes. Due to the importance of those forests, there is growing interest in mapping their components and getting information at an individual tree level to conduct reliable satellite-based forest inventory for biomass and species distribution qualification. Individual tree crown information could be manually gathered from high resolution satellite images; however, to achieve this task at large-scale, an algorithm to identify and delineate each tree crown individually, with high accuracy, is a prerequisite. In this study, we propose the application of a convolutional neural network—Mask R-CNN algorithm—to perform the tree crown detection and delineation. The algorithm uses very high-resolution satellite images from tropical forests. The results obtained are promising—the R e c a l l, P r e c i s i o n, and F 1 score values obtained were were 0.81, 0.91, and 0.86, respectively. In the study site, the total of tree crowns delineated was 59,062. These results suggest that this algorithm can be used to assist the planning and conduction of forest inventories. As the algorithm is based on a Deep Learning approach, it can be systematically trained and used for other regions.

Extraction of sunflower lodging information based on UAV multi-spectral remote sensing and deep learning

[J].The rapid and accurate identification of sunflower lodging is important for the assessment of damage to sunflower crops. To develop a fast and accurate method of extraction of information on sunflower lodging, this study improves the inputs to SegNet and U-Net to render them suitable for multi-band image processing. Random forest and two improved deep learning methods are combined with RGB, RGB + NIR, RGB + red-edge, and RGB + NIR + red-edge bands of multi-spectral images captured by a UAV (unmanned aerial vehicle) to construct 12 models to extract information on sunflower lodging. These models are then combined with the method used to ignore edge-related information to predict sunflower lodging. The results of experiments show that the deep learning methods were superior to the random forest method in terms of the obtained lodging information and accuracy. The predictive accuracy of the model constructed by using a combination of SegNet and RGB + NIR had the highest overall accuracy of 88.23%. Adding NIR to RGB improved the accuracy of extraction of the lodging information whereas adding red-edge reduced it. An overlay analysis of the results for the lodging area shows that the extraction error was mainly caused by the failure of the model to recognize lodging in mixed areas and low-coverage areas. The predictive accuracy of information on sunflower lodging when edge-related information was ignored was about 2% higher than that obtained by using the direct splicing method.

Automated tree-crown and height detection in a young forest plantation using mask region-based convolutional neural network (Mask R-CNN)

[J].

Semantic segmentation of tree-canopy in urban environment with pixel-wise deep learning

[J].Urban forests are an important part of any city, given that they provide several environmental benefits, such as improving urban drainage, climate regulation, public health, biodiversity, and others. However, tree detection in cities is challenging, given the irregular shape, size, occlusion, and complexity of urban areas. With the advance of environmental technologies, deep learning segmentation mapping methods can map urban forests accurately. We applied a region-based CNN object instance segmentation algorithm for the semantic segmentation of tree canopies in urban environments based on aerial RGB imagery. To the best of our knowledge, no study investigated the performance of deep learning-based methods for segmentation tasks inside the Cerrado biome, specifically for urban tree segmentation. Five state-of-the-art architectures were evaluated, namely: Fully Convolutional Network; U-Net; SegNet; Dynamic Dilated Convolution Network and DeepLabV3+. The experimental analysis showed the effectiveness of these methods reporting results such as pixel accuracy of 96,35%, an average accuracy of 91.25%, F1-score of 91.40%, Kappa of 82.80% and IoU of 73.89%. We also determined the inference time needed per area, and the deep learning methods investigated after the training proved to be suitable to solve this task, providing fast and effective solutions with inference time varying from 0.042 to 0.153 minutes per hectare. We conclude that the semantic segmentation of trees inside urban environments is highly achievable with deep neural networks. This information could be of high importance to decision-making and may contribute to the management of urban systems. It should be also important to mention that the dataset used in this work is available on our website.

Semantic segmentation of citrus-orchard using deep neural networks and multispectral UAV-based imagery

[J].

An image is worth 16x16 words: Transformers for image recognition at scale

[EB/OL].

TransUNet: Transformers make strong encoders for medical image segmentation

[EB/OL].

Assessing tree height and density of a young forest using a consumer unmanned aerial vehicle (UAV)

[J].

EfficientNetV2: Smaller models and faster training

[EB/OL].

Conformer: local features coupling global representations for visual recognition

[C]//

CSWin transformer: A general vision transformer backbone with cross-shaped windows

[C]//

Coordinate attention for efficient mobile network design

[C]//

Feature pyramid networks for object detection

[C]//

BiSeNet V2: Bilateral network with guided aggregation for real-time semantic segmentation

[J].

Decoupled weight decay regularization

[EB/OL].

基于特征压缩激活Unet网络的建筑物提取

[J].

DOI:10.12082/dqxxkx.2019.190285

[本文引用: 1]

自动提取城市建筑物对城市规划、防灾避险等行业应用具有重要意义,当前利用高空间分辨率遥感影像进行建筑物提取的卷积神经网络在网络结构和损失函数上都存在提升的空间。本研究提出一种卷积神经网络SE-Unet,以U-Net网络结构为基础,在编码器内使用特征压缩激活模块增加网络特征学习能力,在解码器中复用编码器中相应尺度的特征实现空间信息的恢复;并使用dice和交叉熵函数复合的损失函数进行训练,减轻了建筑物提取任务中的样本不平衡问题。实验采用了Massachusetts建筑物数据集,和SegNet、LinkNet、U-Net等模型进行对比,实验中SE-Unet在准确度、召回率、F1分数和总体精度 4项精度指标中表现最优,分别达到0.8704、0.8496、0.8599、0.9472,在测试影像中对大小各异和形状不规则的建筑物具有更好的识别效果。

Building extraction based on SE-unet

[J].